Willkommen zu Krasse Links No 52. Legt den Mind Control Ray an das Dividuum, heute mäandern wir die Ideologie ins LLM-Werbegeschäftsmodell.

Ich verstehe nicht, wie nicht alle vollkommen durchdrehen bei dem Gedanken, dass unsere Polizeien alle an Palantir hängen?

Jubiläums-Garbage Day mit einer irren Anekdote aus anderer Länder Broligarchien.

In mid-March, a user on Weibo, a Chinese social app similar to X, was doxxed after getting into a fight over K-Pop star Jang Wonyoung. In retaliation, other Weibo users tracked down the pro-Wonyoung stan who revealed the information. They determined it was actually the 13-year old daughter of Xie Guangjun, a high-ranking executive at Baidu, China’s largest search engine. Since then, Xie and Baidu have released multiple public apologies and run an entire internal investigation, all to deny that a teenager was able to use her dad’s panopticon-level corporate access as the atom bomb in a K-pop stan war.

Der empfehlenswerte Youtube-Channel Simplicissimus hat manchmal sogar spannende Reportagen, etwa die Aufarbeitung der Springerkampagnen gegen die Energiewende.

Christian Stöcker, der auch in der Doku zu Wort kommt, hat in den Blaettern für Internationale Politik eine Zusammenfassung + Update zu „Männer, die die Welt verbrennen“ geliefert und es ist wieder sehr lesenswert:

Wir leben in einer Welt, in der eine vergleichsweise kleine Gruppe von Personen, Unternehmen und Institutionen große Macht ausübt – allen voran die Öl-, Gas- und Kohlebranche, aber auch diesen Branchen gewogene, mit ihnen finanziell verbundene, von ihnen finanzierte oder korrumpierte Medienunternehmer, Politikerinnen und Politiker, Lobbyisten, Wissenschaftler, Agenturen, Anwaltskanzleien, Thinktanks und Stiftungen, Medienschaffende, Prominente, Industrieverbände und einige wenige extrem reiche Menschen.

Ich finde gut, dass Stoecker die Scheu abgelegt hat, wie ein Verschwörungstheoretiker zu klingen, denn in diesen Zeiten ist die gefährlichste Verschwörungstheorie, dass es keine Verschwörung gibt – während uns die materiellen Resultate tatsächlicher Verschwörungen immer mehr zum Hals steigen.

Klimabedingte Katastrophen vernichten schon jetzt Jahr für Jahr Milliardenwerte und töten mindestens Tausende, vermutlich eher Zehntausende von Menschen und ein Vielfaches an Tieren. Teile Südeuropas werden sich in absehbarer Zeit in Wüsten- oder Steppenlandschaften verwandeln, Teile Afrikas, Asiens, Indiens und auch Nordamerikas könnten unbewohnbar werden. Die Wanderungsbewegungen der Gegenwart, von denen sich industrialisierte, reiche Regionen wie Nordamerika oder Europa schon heute überfordert fühlen, werden sich im Vergleich zu dem, was bevorsteht, winzig ausnehmen.

Ich war gerade in der Türkei und besuchte die Ruinen der untergegangen römischen Metropole Ephesos, die einst das wichtigste römische Handelszentrum im Mittelmeer war und die zweitgrößte Stadt im Reich nach Rom.

Das Ende von Ephesos wurde nicht durch plündernde „Barbaren“ besiegelt, sondern durch den Fluss Mäander, der immer mehr Sand in das Hafenbecken spülte, bis der nicht mehr nutzbar war. Die ganze Stadt musste deswegen aufgegeben werden.

Wir vergessen manchmal, dass all unsere Städte an ihrem bestimmten Ort gebaut sind, aufgrund der geographischen und damit auch klimatischen Lage. In Ephesos wurde mir plötzlich schmerzhaft greifbar, dass all unsere Städte zum „stranded Asset“ werden können, wenn sich das Klima jetzt radikal ändert. Das ist das schwere zu begreifen: die Katastrophe besteht nicht in diesem oder jenen schlimmen Wetterereignis – es ist der Wandel ansich. Plötzlich ist alles am falschen Ort.

Die Klimaforschung basiert auf Physik, und Physik verhandelt nicht. Wenn wir nicht aufhören, CO2 zu emittieren, führt das in die Katastrophe, das ist unzweifelhaft. Neoliberale Ideologie dagegen erhebt den Anspruch wissenschaftlicher Allgemeingültigkeit, ist aber längst empirisch an der Realität gescheitert. Dieser Denkrichtung verdanken wir schließlich die Tatsache, dass der Planet sich auf einem Entwicklungspfad befindet, der die menschliche Zivilisation ins Verderben stürzen könnte. Auch deshalb, weil viele ihrer Wortführer jahrzehntelang darauf beharrten, dass man sich auf die Erkenntnisse der – empirischen, physikalisch begründeten – Klimaforschung nicht verlassen könne.

Wir leben längst in einer Wirklichkeit, in der sich fast die gesamte politische Kaste von der faktischen Realität der Klimakatastrophe abgekapselt hat. Stattdessen gelten heute die mit den Fakten als die Ideologen und werden von einer immer aggressiveren Politik offen angriffen.

Ein Teil des Problems ist, dass der Widerstand ausbleibt und das liegt unter anderem daran, dass Menschen immer noch in den Erzählungen des Marktes festhängen. In dieser Erzählung erzwingt der ständig sinkende Preis erneuerbarer Energien ihren Durchbruch. Aber diese Erzählung hat dasselbe Problem, wie alle Markterzählungen: sie blendet die Politik, also Macht, vollkommen aus.

Hier eine Gegenerzählung im Sinne der Politischen Ökonomie der Abhängigkeiten:

- Die derzeit massiv zugebauten Gaskraftwerke sind Infrastrukturen und damit Pfadentscheidungen. Diese Pfadentscheidungen wirken sich als „Lockin“ nicht nur auf die Energieversorgung aus (dann können wir also doch wieder mehr Gasheizungen verbauen, oder?), sondern auch auf den Diskurs.

- Der Gas-Lockin kann dann als Asset in der kommenden Kampagne gegen den „Europäischen Emissioshandel“ verwendet werden. 2027 ist eine ordentliche Steigerung des CO2-Preises vorgesehen und der Grund, warum sich die Fossilindustrie nicht dazu verhält, ist, dass sie nicht an seine Weiterexistenz glaubt. Wenn mitten in der Rezession der Gaspreis steigt und Springer und die von Stöcker beschriebene Fossilmänner-Lobby wieder eng zusammenarbeitet, wird es ein leichtes sein, den Handel politisch zu kippen. Die Heizhammerkampagne war eine gute Übung.

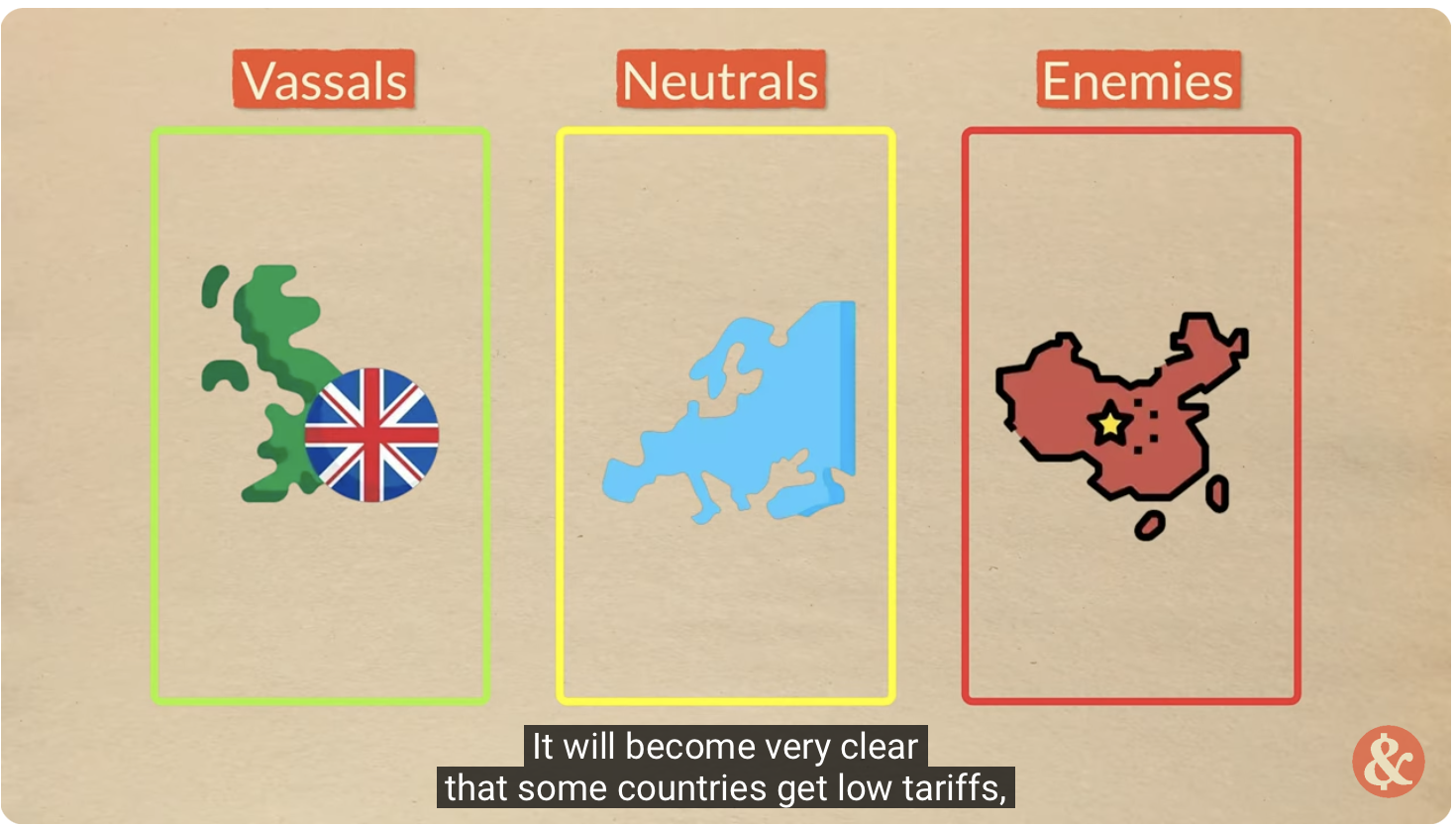

- Man darf dabei die USA nicht aus den Augen verlieren, denn Trump hat mit „Drill Baby Drill“ der Fossilmafia ihr Existenzrecht versprochen. Schon jetzt hat er zum Beispiel Japan drauf gedrängt, mehr amerianisches Gas und Öl abzunehmen, ihr wisst schon: wegen des „unfairen Außenhandelsüberschusses.“ Nimmt man Trumps Obsession mit Fossiler Energie und mit „ausgeglichener Handelsbilanz“ zusammen, erhält man das Playbook für das Endgame dieses Handelskrieges: „Befreundete Staaten“ sind Staaten, die den Amerikanern ihre Rohstoffe in einer Menge abkaufen, die ihr Handelsüberschuss mit den USA ausgleicht und sich damit dem Fossillockin verschreiben. Und im Zweifel wird der Fossillockin militärisch durchgesetzt.

- Fragt sich nur, wie wir all das Öl und Gas verbrauchen sollen, ohne, dass der Energiepreis kollabiert und hier ist die Antwort natürlich KI, irgendwas Pre-AGI, Super Agents, Super Duper Agents, Super Duper Agents in Lila, unendlich viele AI-Friends im Metaverse, Spam- und Phishing-Tsunamis, Brandolinis Lawfare und automatisierte Kill-Drones. Außerdem natürlich Bitcoin-Mining, Trump-Coin-Minung und Crypto-KI-Coin-Mining, LLM-Tokens, DOGE’s Daugters Memecoins, Musk for God Tokens, whatever. Wenn Silicon Valley eines gezeigt hat, dann dass sie unendlich viele Wege finden, Energie zu verschleudern.

- Natürlich wird Trump Deutschland zusätzlich unter Druck setzen, unsere Zölle gegen China hochzuziehen, um die Elektrifizierung weiter zu verzögern. Die Oligarchen des Westens sehen ihre Heimatländer zunehmend als teil eines untergehenden Fossil-Imperiums, dass seine wirtschaftlichen Felle in einer elektrifizierten Welt davonschwimmen sieht. Die Deutsche Autoindustrie ist hier nur ein plakatives Beispiel.

- Ich will nichts beschreien, aber es ist absolut vorstellbar, dass Chinas Elektrifzierungsmacht zum wesentlichen Grund für einen militärischen Konflikt zwischen China und dem Westen wird. Und wenn Trump ernst macht, wird Merz uns dabei nicht raushalten.

Ich weiß, es ist schwer, aber ihr müsst Euch aus der alten Welt und ihren Gewissheiten verabschieden. All die Narrative vom „Markt“, vom „Recht“, von der „Vernunft“ oder der „Demokratie“, die uns irgendwie retten werden, haben spätestens seit Trump II und Merz ihre Gültigkeit verloren.

Wir leben jetzt in den Ausläufern des Fossilimperiums, das um sein Leben kämpft und im Gegensatz zu Trump und Merz haben wir vergessen, was Gewalt alles kann. Wenn wir nicht aufwachen und anfangen zu kämpfen, ist eine 6 Grad-Welt nicht vom Tisch.

Eine Studie, die das Ausmaß der LLM-Nutzung unter Studierenden zu fassen versucht:

In 2025, we find that the student use of AI has surged in the last year, with almost all students (92%) now using AI in some form, up from 66% in 2024, and some 88% having used GenAI for assessments, up from 53% in 2024. The main uses of GenAI are explaining concepts, summarising articles and suggesting research ideas, but a significant number of students – 18% – have included AI-generated text directly in their work.

Im New York Magazine ist ein vielbeachteter Artikel über den Einfall von LLMs in die universitäre Lehre erschienen, mit vielen erhellenden Einzelgeschichten.

Professors and teaching assistants increasingly found themselves staring at essays filled with clunky, robotic phrasing that, though grammatically flawless, didn’t sound quite like a college student — or even a human. Two and a half years later, students at large state schools, the Ivies, liberal-arts schools in New England, universities abroad, professional schools, and community colleges are relying on AI to ease their way through every facet of their education. […]

“College is just how well I can use ChatGPT at this point,” a student in Utah recently captioned a video of herself copy-and-pasting a chapter from her Genocide and Mass Atrocity textbook into ChatGPT.

Erzählt wird auch von Wendy, die ihre gesamten Essays mit ChatGPT plant und argumentativ bestückt, bevor sie nur noch die Lücken füllt und das deswegen gar nicht als „Cheating“ ansieht.

“Honestly,” she continued, “I think there is beauty in trying to plan your essay. You learn a lot. You have to think, Oh, what can I write in this paragraph? Or What should my thesis be? ” But she’d rather get good grades. “An essay with ChatGPT, it’s like it just gives you straight up what you have to follow. You just don’t really have to think that much.” […]

“I use AI a lot. Like, every day,” she said. “And I do believe it could take away that critical-thinking part. But it’s just — now that we rely on it, we can’t really imagine living without it.”

Wenn man anfängt zu schreiben, ist man schlecht. Man wird mit der Zeit besser, indem man ständig alles Mögliche ausprobiert und man die Pfade, die nicht funktionieren, verwirft. Wenn man dann am Ende funktionierende Pfade des Schreibens für sich gefunden hat und plötzlich fähig ist, einen klaren Gedanken auf Papier zu bringen, dann steckt hinter dieser Fähigkeit ein über die Zeit aquiriertes Orientierungswissen im Raum der Semantiken, also des Denk- und Schreibbaren, und jeder Satz den man dann aufschreibt, entsteht vor dem Hintergrund dieses teilausgeleuchteten Möglichkeitsraums.

Das gilt nicht nur fürs Schreiben (Sprechen/Denken) im Allgemeinen, sondern auch für das Schreiben (Sprechen/Denken) über bestimmte Themen.

Jemand der kompetent über Geschichte schreiben kann, kann das noch lange nicht über Physik und das kompetente Sich-Ausdrücken in einem Feld gilt deswegen als Beleg für die Erlangung dieses spezifischen Orientierungswissens.

Die LLMs sind deswegen ein enorm attraktiver Shortcut, weil man sich damit zu jedem beliebigen Thema orientiert aussehende Sätze ausspucken lassen kann und so ohne jedes Orientierungswissen dessen „Beleg“ produzieren kann.

Was nichts anderes bedeutet, als dass wir ein völlig anderes Bildungssystem brauchen, wenn wir als Menschheit nicht so sehr verblöden wollen, dass ChatGPT tatsächlich zur „Super Intelligence“ wird – relativ gesehen.

Im Atlantic beschäftigt sich Mike Caulfield ebenfalls mit dem Descilling durch KI.

There’s a good analogy in maps. Traditional maps showed us an entire landscape—streets, landmarks, neighborhoods—allowing us to understand how everything fit together. Modern turn-by-turn navigation gives us precisely what we need in the moment, but at a cost: Years after moving to a new city, many people still don’t understand its geography. We move through a constructed reality, taking one direction at a time, never seeing the whole, never discovering alternate routes, and in some cases never getting the sense of place that a map-level understanding could provide. The result feels more fluid in the moment but ultimately more isolated, thinner, and sometimes less human.

Die Analogie zur Karte, bzw. Orientierungswissen ist die beste Art über LLMs nachzudenken, doch während wir auf das geographische Orientierunsgswissen gegebenenfalls tatsächlich verzichten können (können wir?), bin ich mir mit dem „Semantischen Orientierungswissen“ deutlich weniger sicher.

Gottseidank bin ich offenbar nicht der Einzige, der darauf gekommen ist, LLMs als Semantik-Maschinen, statt als „kognitive Minds“ zu verstehen.

Alison Gopnik, a researcher who specializes in cognitive development, has proposed a better way of thinking about LLMs: These systems aren’t companions or nascent intelligences at all. They’re “cultural technologies”—tools that enable people to benefit from the shared knowledge, expertise, and information gathered throughout human history. Just as the introduction of the printed book or the search engine created new systems to get the discoveries of one person into the mind of another, LLMs consume and repackage huge amounts of existing knowledge in ways that allow us to connect with ideas and manners of thinking we might otherwise not encounter. In this framework, a tool like ChatGPT should evince no “opinions” at all but instead serve as a new interface to the knowledge, skills, and understanding of others.

Die Gefahr, die von LLMs ausgeht, ist folglich mehr eine kulturelle Gefahr, als eine individuelle und jetzt höre ich mich sicher etwas konservativ an, aber ich finde schon, dass wir vor dem Verlust von Kultur – nicht verstanden als „Kanon“, sondern als „semantische Praxis“ – Angst haben sollten.

Mark Zuckerberg in einem Tech-Bro-Podcast so:

The average American has fewer than three friends, fewer than three people they would consider friends. And the average person has demand for meaningfully more. I think it’s something like 15 friends or something.

Der Zynismus, wie man von ganz oben im Silicon Valley auf die selbst mitverschuldete Lonlyness-Pandamic als riesen Business Opportunity schielt ist atemberaubend.

Im Money Stuff Newsletter nimmt Matt Levine Zuckerbergs Rechnung zum Anlass, den Total Adressable Market für diese Art von Geschäftsmodell zu errechnen:

The total addressable market for friends is 15 per person, and right now humans are only providing about three friends per person, which leaves an opening for Meta to capture as much as 80% of human (well, human-ish) interaction.[1] That would be pretty good.

Max Read versucht anhand von aktuellen Trends und dem oben zitierten Interview die kommenden Geschäftsmodelle von LLMs zu ergründen und landet natürlich bei Werbung.

Zuckerberg doesn’t mention ads, but if “Coke Zero Claude” is a sort of L.L.M. version of the Google model–a user’s search for information is bracketed by and interspersed with sponsored content–you can equally imagine an L.L.M. version of the Facebook model, in which engagement is driven by “social” interaction–with, say, an L.L.M. chatbot girlfriend or boyfriend, speaking in the voice of your favorite wrestler or Top Chef contestant–around which advertisements and sponsorships can be sold. It’s one thing to have the L.L.M. you use to write your essays for English class keep talking about Coke Zero; it’s another to have the A.I. girlfriend you talk to every day suggest you buy a cool and refreshing zero-calorie soda after your hard day at work.

Ich hatte bereits mehrfach auf die Gefahr von Abusive Relationsships als Geschäftsmodell hingewiesen und auf die bereits mobilisierte Verwendung von LLMs als Massen-Sprechakt-Waffen.

Hier kommt gewissermaßen beides zusammen: man stellt eine emotionale Abhängigkeit her, um über individualisierte, intime aber doch im Aggregat massenhafte Sprechakt-Steuerung das Denken und Verhalten von Millionen Menschen zu manipulieren.

Ich kenne mittlerweile etliche Beispiele, in denen Menschen Chatbots als tägliche Konversationspartner, seis als Freundes- oder Coach- oder Therapie-Ersatz verwenden. Da werden Beziehungsdinge geklärt, Karrieretipps erfragt, fixe Ideen verifiziert oder Komplexe Sachverhalte „durchdacht“.

Das ist die eigentliche Pointe: LLMs müssen es gar nicht zur „AGI“ schaffen, um die Kontrolle über Millionen von Leben zu erlangen und dass diese Kontrolle dann von keinem „künstlichen Bewusstsein“ ausgeht, sondern von einem Konzern, beruhigt dabei nur wenig.

Warum die Unternehmen das wollen ist schon klar, aber ich rätsel noch daran, warum sich sich so viele Menschen freiwillig zu SIMS-artigen KI-gesteuerten NPCs machen lassen?

Auf Pluralistic glaubt Cory Doctorow nicht an die Werbekraft von LLMs.

Cory bewertet wie ich die Erzählungen von „Cambrige Analytica“ oder dem „Überwachungskapitalismus“ kritisch als überkandidelten Critihype und macht sich entsprechend auch bei LLM-Werbung über die Erzählungen eines „Mind Control Rays“ lustig.

This is a facially absurd proposition. After all, everyone who’s ever claimed to have perfected mind-control – Rasputin, Mesmer, MK-ULTRA, neurolinguistic programming grifters and pathetic „pick up artists“ – was a liar. Either they were lying to themselves, or to everyone else. Or both.

Ich glaube aber, hier irrt Doctorow. Zwar hat er recht, dass „Mind Control Rays“ eine urban Legend sind, die nie gestimmt hat, aber das liegt nicht an dem „Ray“-Teil, sondern an dem „Mind“-Teil der Erzählung.

Weil wir keine Indivuduen sind, die die Welt durch ihr „Mind“ beobachten, sondern Dividuen, die einander beim Beobachten der Welt beobachten, haben wir keinen in sich geschlossenen Raum des Denkens, keine „Res Cogitans„, sondern navigieren beim Sprechen/Schreiben/Denken als Thin Clients die verteilte Cloudinfrastruktur der Sprache.

Weil wir semantische Wesen sind, die sich nie außerhalb des semantischen Raums bewegen, ist unser Denken immer schon teil des „Res Extensa“. Das bedeutet, dass wir zwar nicht durch „Mind Control“ manipulierbar sind, wohl aber durch eine Manipulation unserer semantischen Umwelten.

Und das ist der Ort, an dem LLMs wirksam sind: Als Massensprachakt-Waffen und mehr noch in emotionalen Abhängigkeitsbeziehungen gestalten sie unsere semantische Umwelt um und steuern damit subtil den Möglichkeitsraum der uns zugänglichen und plausibel erscheinenden semantischen Pfade.

Nein, es gibt keine „Mind Control Rays“, aber es gibt Ideologie und dass sie wirksam ist, belegt unter anderem der widerspenstige Erfolg der „Mind Control Ray“-Erzählung, sowie die Erzählung vom „Markt“ oder die von der „Intelligenz“.

Der Historiker Quinn Slobodian dröselt in einem Stück für den Guardian die Obsession mit Intelligenz im neuen Faschismus auf.

IQ fetishism had a history in the valley; one of the pioneers of the need to take eugenic measures to increase IQ was William Shockley, the inventor of the transistor (the building block of computer chips), who proposed that people with an IQ below the average of 100 should be given $1,000 per IQ point to sterilise themselves. In 2014, the American tech billionaire Peter Thiel said the problem with the Republican party was that too many of its leaders were “lower IQ” compared with those in the Democratic party. IQ was also a common focus of discussion on the popular blog Slate Star Codex and elsewhere in the so-called “rationalist” community.

All of this would have remained a quirky symptom of San Francisco Bay Area chatboards were it not for the recent alliance between the world of the tech right and the governing party in Washington DC. The idea that intelligence is hardwired and resistant to early intervention or improvement through state programmes – that IQ is meaningful and real – brings us closer to what Murray and Herrnstein were advocating for in The Bell Curve in the 1990s, what they called “living with inequality”.

Von dort gibt es eine direkte Linie zu Trump und Musk.

Musk, like Trump, frequently refers to IQ as if it is a meaningful and important number. If you believe it is hardwired, then you too would want to destroy the Department of Education and stop trying to create standardised outcomes.

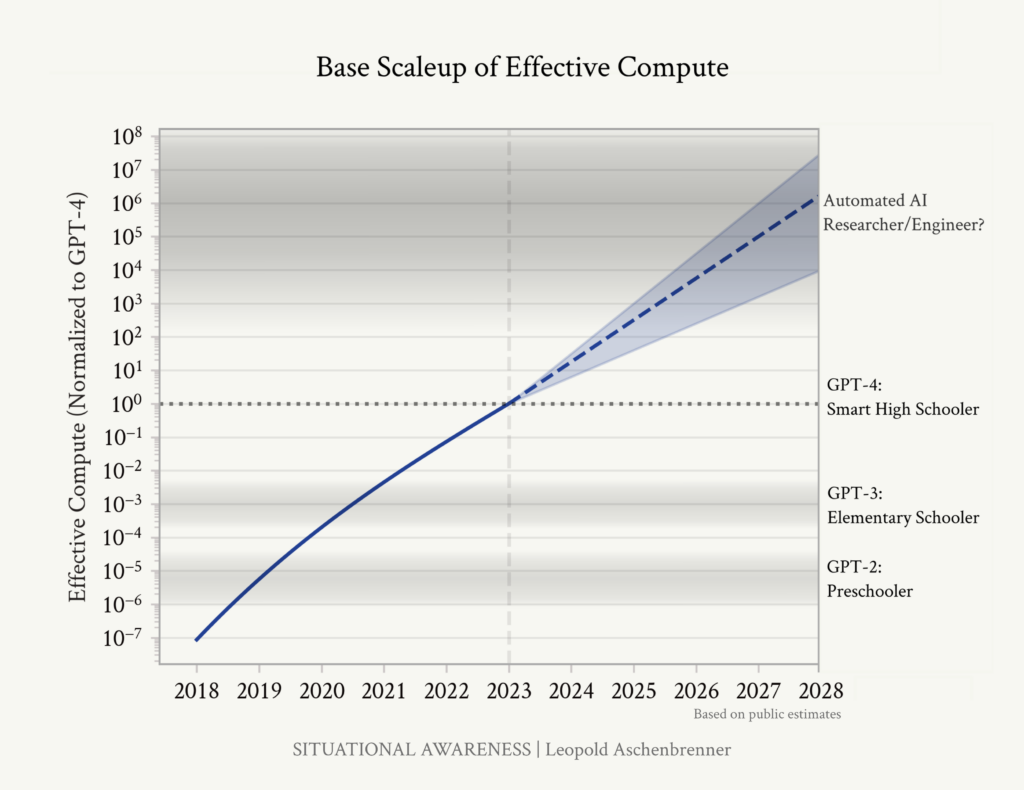

Dahinter steht die allgemeine Vorstellung von Intelligenz als Lineare Funktion, die von der Amöbe über die Tierwelt bis zum Harvard-PHD verläuft und in der sich die KI-Bros selbst als Spitze erzählen, nur demnächst geschlagen durch den selbstgeschaffenen Intelligenz-Gott namens „AGI“, wie es neulich Leopold Aschenbrenner einst so schön skizzierte.

Wenn ich mir ein Szenario wünschen düfte, dann wäre es, dass wir durch diesen ganzen Quatsch wenigstens ein besseres Verständnis dafür bekommen, was Intelligenz wirklich ist, so dass wir bald sehr herzlich über die KI-Bros und ihre „unintelligente“ Kindervorstellung von Intelligenz lachen können.

James Poniewozik schreibt kluges in der NyTimes über die Serie Andor, deren zweite Staffel gerade auf Disney Plus läuft.

A sense of tragedy is built into the series’s premise. “Andor” is a prequel to the 2016 movie “Rogue One,” in which Cassian goes on a fatal mission to retrieve the blueprints for the Death Star, the planet-killer that Luke Skywalker destroyed in the original “Star Wars” (now known as “A New Hope”).

Prequels are often where dramatic tension goes to die: How invested can you be in a story whose outcome you already know? The genius of “Andor,” created by Tony Gilroy, is to make that knowledge an asset.

With some exceptions, like Mon Mothma (Genevieve O’Reilly), the senator who will go on to lead the rebellion, “Andor” is largely about characters who will never live to see victory. That we know this — that on some level, they know this — is the whole point.

Freed from the “what happened” of the rebellion, “Andor” becomes a space-opera entertainment about revolutionary praxis. What radicalizes people? (The loss of loved ones; the loss of agency and hope; the loss of anything further to lose.) How does a rebellion form and spread? How do you build a movement that unites establishmentarians and militants? What — and who — is an acceptable sacrifice?

Ich hatte die Serie bereits in einem frühen Newsletter als wichtige Inspiration für mein derzeitiges politisches Denken beschrieben und das kann ich für die zweite Staffel nur noch mal bekräftigen. Andor bietet das dringend nötige Gegengift gegen die vorherrschende Hegemonie des Mitteextremismus, die auch hierzulande jedes politische Handeln erstickt.

Dass ausgerechnet das disneyfizierte und extraktivistisch abgegrabbelte Star Wars Franchise die politisch relevanteste Serie der aktuellen Zeit hervorbringt, will uns irgendwas sagen, von dem ich noch nicht sicher bin, was es ist, außer, dass wir in weirden Zeiten leben.

Zusammen mit meiner Freundin, der Philosophin Susann Kabisch werde ich auf der re:publica die Verstrickungen des Widerstands bei Andor und bei einer anderen großartigen der Serie, Sense8, genauer analysieren.