Willkommen zu Krasse Links No 73. Absorbiert eure Supply-Schocks, heute drohen wir Mamdani mit Übergangswahrscheinlichkeiten, um in der Informations-Kanalisation eine antifaschistische Ökonomie zu errichten.

Ryan Broderick mit der Vogelperspektive auf die Mamdani-Wahl.

As chaotic as all of this is — and will continue to be until the midterms — there is one very clear conclusion here. American politics has changed. The Republicans felt it first. And the same way the Tea Party ate the GOP out from the inside, laying the groundwork for Trump and his MAGA rebrand, so too has what we once called The Dirtbag Left begun devouring the Democrats. The effects of the internet, a deeply alienating globalized economy, and the rise of a technofeudal billionaire class have finally cracked American Democrats wide open. We’re in a class war and it plays out on video feeds and those same billionaires own the algorithms that decide what side of it you end up on. And Mamdani and his team — and the burgeoning DSA political machine — arrived at the exact moment Americans were ready to talk about class and found the best way to hijack our new world of short-form (and long-form) video to make sure you actually heard them. Successfully turning his mayoral campaign into not just a referendum on President Donald Trump and the horrors of his second first year in office, but also the Democratic establishment. And with Mamdani’s big win this week, it’s safe to assume the Democratic civil war will be arriving on a ballot near you soon.

Wenn jemand wie Mamdani auftaucht, sortiert sich um ihn das politische Feld neu und machmal auch „besser“, in dem Sinne, dass die Bruchkanten des eigentlichen Konfliktes deutlicher zur Geltung kommen. In allen heute dafür relevanten Dimensionen ist Mamdani eine wichtige Orientierungsschneise für kommende Konflikte.

Netzwerkdenken bedeutet, Strukturen zu sehen, statt nur Objekte oder Leute. Es bedeutet, sich immer wieder die eigene Verortetheit im Netzwerk vor Augen zu führen. Netzwerkdenken bedeutet in Pfaden zu denken, denn der Pfad ist der einzige Weg durch das Netzwerk, den wir kennen. Netzwerkdenken bedeutet aber auch, in Dimensionen, statt in Kategorien zu denken und in Übergangswahrscheinlichkeiten, statt in Kausalitäten.

Das Gute ist, dass wir alle ein bisschen Netzwerkdenken gelernt haben. Ganz besonders in der Zeit Pandemie wurden wir angehalten, uns als Teil von exponentiellen Graphen zu imaginieren, die wiederum auf einem Netzwerkmodell von Ansteckungsereignissen basiert.

Das, was wir als den „R-Wert“ (oder auch R0) kennengelernt haben, ist die Übergangswahrscheinlichkeit für unfinfizierte Menschen, in der Gruppe der Infizierten zu landen.

An R können wir uns klar machen, was eine Übergangswahrscheinlichkeit ist. R bedeutet nicht, dass du dich auf jedenfalls ansteckst und es bedeutet nicht, dass du auf keinen Fall ansteckst. Übergangswahrscheinlichkeiten funktionieren anders als Kausalitäten.

R0 ist zudem ein Durchschnittswert und sehr unpräzise, wenn man ihn auf sich selbst anwendet. Übergangswahrscheinlichkeiten sind in Wirklichkeit zusammengesetzt aus den Übergangswahrscheinlichkeiten der heterogenen Strukturen, in denen Übergänge tatsächlich stattfinden.

Auf das Dividuum heruntergebrochen gibt es große Unterschiede des persönlichen R-Wertes: Gehst du wenig aus dem Haus, senkt das dein R, trägst du Maske, senkt das dein R, lässt du dich Impfen senkt das dein R, usw.

Man kann das sogar bis herunter auf Ereignisse auflösen: Eine Veranstaltung mit vielen Leuten besuchen erhöht dein R, Zugfahren erhöht dein R, mit Menschen draußen statt drinnen treffen, reduziert dein R.

Ein Beispiel: Ich war die bis letzte Woche zwei Wochen lang unterwegs, von Berlin, nach München, nach Hannover, nach Köln, nach Stuttgard und über Hannover wieder zurück. Ich war auf Theaterveranstaltungen, auf einer Hochzeit, habe ein Seminar gegeben und habe dabei ca. 6 längere Bahnfahrten zurückgelegt und ich habe nie Maske getragen und dennoch bin ich ohne eine Infektion durchgekommen.

Ein anderes Beispiel: Am Wochenende habe ich einen Freund auf dem Land besucht und zusammen haben wir ein bisschen draußen gearbeitet. Es waren auch zwei andere da, aber vor allem habe ich mit meinem Freund Zeit verbracht und vor allem draußen. Aber meinem Freund ging zum Abend hin immer schlechter und als ich schon wieder zu hause war, schickte er mir das Foto mit dem positiven Test. Und jetzt sitze ich hier mit meiner Covid Infektion.

Das scheint erstmal der Aussage von R zu widersprechen, oder?

Tja, das ist das Problem, wenn man in Kausalitäten denkt. Übergangswahrscheinlichkeiten produzieren contra-intuitive Ereignisse schon zum Frühstück!

Übergangswahrscheinlichkeiten repräsentieren in Wirklichkeit Pfade im Netzwerk, Ansteckungspfade im Falle von R. R0 ist ein aggregiertes Maß über alle Ansteckungspfade, also der Baumstruktur des Infektionsgraphen. Epidemiologie abstrahiert reale Pfade zu Wahrscheinlichkeiten und Wahrscheinlichkeiten zu Raten. Der R-Wert ist die komprimierte Form eines Netzwerks, das man nicht sehen, aber berechnen kann.

Oder andersrum: Wir, bzw. unsere direktphysischen Interaktionen miteinander, bilden das Netzwerk der Pfadgelegenheiten, in dem sich das virus bewegt. Was wir eigentlich machen, wenn wir versuchen, unseren R-Wert zu senken, ist unser relatives Zentralitätsmaß im Netzwerk der viralen Pfadgelegenheiten zu reduzieren. Idealerweise kapseln wir uns vom Netzwerk ab, was ich gerade machen muss, so ein Scheiß.

Die Epidemiologen können natürlich nicht jeden einzelnen Pfad verfolgen, aber für ihre Modelle braucht es das nicht.

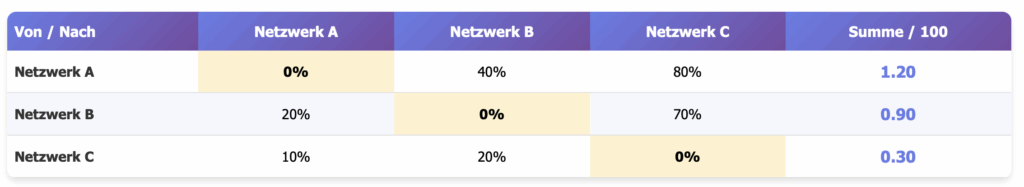

Ein Markow-Modell ist ein iterativer Prozess, der zwischen endlich vielen Zuständen – etwa gesund, infiziert, genesen – entlang von Übergangswahrscheinlichkeiten wechselt. Im Zentrum steht also die Übergangswahrscheinlichkeits-Matrix und jede Zeile steht für den aktuellen Zustand, jede Spalte für den möglichen nächsten. Multipliziert man den momentanen Zustandsvektor mit dieser Matrix, erhält man die Wahrscheinlichkeitsverteilung des nächsten Zeitschritts. In jeder Iteration „vergisst“ der Prozess die vorherigen Schritte und handelt entlang der veränderten Zustände und ihrer Übergangswahrscheinlichkeiten im ewigen Jetzt. Und trotzdem ergibt sich eine realistische Dynamik.

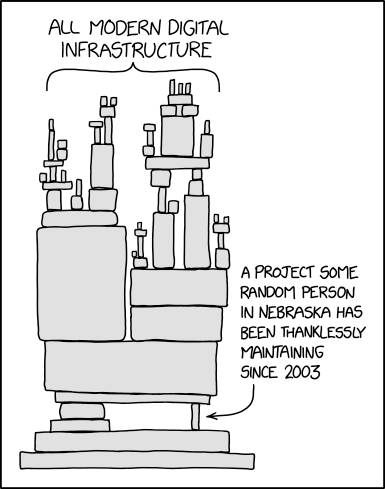

Weil wir keine Individuen sind, die einfach tun und lassen, was sie wollen, sondern Pfadopportunisten in einem Labyrinth aus Pfadgelegenheiten, agieren wir in vielerlei Hinsicht selbst wie Viren oder Markowmodelle: Wir erinnern uns nicht an unsere Pfade (siehe Infrastrukturvergessenheit), aber reproduzieren ihre Wahrscheinlichkeiten.

Jedenfalls hier ein ganz einfachens SIR-Modell zum Rumspielen.

Issie Lapowsky mit einem Text in Politico, der das Potential hat, die Demokratische Partei zu revolutionieren.

Future Forward ist der Super-PAC, der bei der US-Wahl einen großen Teil der demokratischen Gelder für Werbung auf Plattformen ausgeben hat und weil der auch bei den Tech-Bros beliebt war (ja, einige haben auch für Demokraten gespendet), war es bei dieser Wahl auch der mächtigste Super-Pac und gab die Richtung vor.

Once the go-to Democratic super PAC behind Barack Obama’s 2012 and Hillary Clinton’s 2016 presidential campaigns, Priorities was effectively sidelined in 2024. Future Forward received the Biden campaign’s blessing, and Silicon Valley megadonors, drawn in by the group’s data-driven approach, funneled their fortunes into Future Forward’s giant pot. In the end, Future Forward’s PAC spent more than $500 million on ads — nearly 70 percent of all presidential super PAC spending from Democrats according to one count. Priorities, by contrast, spent about $2 million.

Von Future Forward kam nicht nur Werbegeldsteuerung hin zu den Plattformen, sondern auch auf die inhaltlich-strategische Ausrichtung hatten sie großen Einfluss, denn da ist eben alles „datengetrieben“.

Throughout 2024, Future Forward worked closely with the Democratic data firm Blue Rose Research, which tested thousands of ads from both parties, including ads Future Forward commissioned and ads made by other groups. Those tests found that the ads with clear economic messages about lowering the cost of living consistently proved the most persuasive to the most people. Future Forward cut its own ads from an array of ad makers in eight languages and produced different versions to appeal to different demographics. It spent heavily online, outspending Republicans in battleground states two-to-one on digital platforms. But for the most part, Future Forward’s ads stayed relentlessly on message, with 71 percent of them focused on the economy, according to a Future Forward adviser who was granted anonymity to speak with POLITICO Magazine because they didn’t have permission to go on the record.

Aber der Versuch, einer angeblich breiten Mitte in den Umfragen hinterzurennen, um sie mit halbseidenden Versprechungen zu Preisstabilität via getargeteten Ads zu catchen, vergisst Menschen zu überzeugen, Themen zu setzen und das Narrativ zu kontrollieren.

Die Trump-Campaign hat das ganz anders gemacht.

One example of this she frequently points to is the infamous “They/Them” attack ad, which Priorities tracked. It featured Harris talking in 2019 about paying for gender-affirming surgery for trans prisoners. The ad began life as a bit of opposition research, posted to the Trump War Room account on X. The post gained steam online until, in September of 2024, the Trump campaign ran it as an ad. The more pickup the ad got — in the news and on podcasts like The Breakfast Club — the more money Trump’s camp put behind it.

“That ad didn’t come from a poll telling them to talk about that clip,” Butterfield said. “They used the internet to signal to them that it was effective rather than a poll or a focus group.”

Democrats never really responded to the claims in the ads, though. Future Forward could see that the ad was effective. But according to the Future Forward adviser, the group decided that it was up to the Harris campaign itself, not an outside super PAC, to decide what kind of stand to take on the issue. According to The New York Times, the Harris campaign did craft a rebuttal ad, but it fell flat in ad tests and was shelved. And so, in another moment that Butterfield likens to the post-debate period, Democrats left one of Trump’s stickiest digs effectively unanswered.

After Trump won, one post-election poll found that, of all of the issues, from immigration to Israel, voters thought Harris had focused excessively on transgender topics. In reality, she hadn’t said much about those issues at all. It was Trump’s team doing the talking.

Es ist aber nicht nur eine falsche Strategie. Es ist eine veraltete Strategie in einer völlig veränderten Medienlandschaft.

Between 2020 and 2024, people who consumed at least three hours of YouTube a day had moved 10 points toward Trump — a bigger swing than Black voters, Black men, young voters and a slew of other categories that were dominating headlines.

“The driver of behavior in ‘24 was so much more about your media consumption,” Butterfield said.

Ich hatte das in Krasse Links No 35 so zusammengefasst:

Was die Pandemie gemacht hat, ist die Welt neu zu verdrahten. Die materielle Mediengeschichte der Pandemie kann man an vielen Daten ablesen, etwa wie das Öffentliche Leben zum Stillstand kam und sich nie wieder ganz erholte, weil Dritte Orte – Orte jenseits von Arbeit und Zuhause – ebenfalls mehr und mehr verschwunden sind.

Die Menschen sind seither einsamer, aber haben ihre Sozialität auch verstärkt ins Internet verlagert, wo sie „Influencer*innen“ folgen, eine Menge Podcasts abonniert haben, und ihre Informationen vermehrt aus Social Media beziehen. Als sie dann noch Aktien-Trading-Apps luden und Crypto kauften, richteten sich auch ihre Aufmerksamkeitskanäle auf die boomende Investment- / Cryptoinfluencer*innen-Szene aus und sie wurden empfänglich für deren Botschaften des baldigem Kollaps, usw.

Das ist nicht nur ein Shift von „Aufmerksamkeit“ und „Medienkonsum“, als wäre das sowas wie Süßigkeiten Essen. Es ist eine völlig andere Informations-Kanalisation entstanden, die sich seit der Pandemie nicht nur verfestigt hat, sondern auch pfadopportunistisch gewachsen ist.

Aber Experimente mit aggressiveren Clips von Demokratenseite zeigen, dass die Demokraten in dieser anderen Informations-Kanalisation nicht chancenlos sind.

But throughout the summer and early fall, Priorities’ data consistently found that the Epstein Files were the one political topic that continued to break through online. That led Priorities to create an ad about the shadowy powers of the billionaire class, drawing a straight line between Trump, Epstein and the Pennsylvania megadonor Jeffrey Yass who’s backing the opposition. The ad doesn’t make any claims about Yass, but it pushes the idea that money in politics corrupts. “With money and power, who knows what you can get away with,” the voiceover intones.

Like the “They/Them” ad before it, it’s a bit of a conceptual stretch, and it didn’t perform particularly well on ad tests. But amid a crowded field of ads featuring stale B-roll of judges in robes, Abbott said it’s worth leaning into a message “that’s catching people’s attention.” In the first few days the ad ran, Priorities said, it performed better on YouTube surveys than other more traditional ads about the race, and users were twice as likely to actually click through.

Wir, unsere Gespräche am Esstisch, unsere Social Media accounts, die Plattformen, die wir nutzen, Podcasts die wir nacherzählen, Newsletter, die wir weiterleiten, Bücher, die wir weiterempfehlen, die klassischen Medien, dir wir trotzdem gucken, etc. All das bildet das Netzwerk der Pfadgelegenheiten, durch das die Narrative perkulieren. Wege zu dir, Wege von dir weg, gute Wege, breite Wege, weite Wege, schnelle Wege. Wege nach oben, Wege nach unten, Wege in die eine Community oder die andere.

Wer in Zukunft medial erfolgreich sein will, muss sich obsessiv in diese Informations-Kanalisation reindenken, muss ein Orientierungswissen darin erlangen und lernen, plausible Pfade darin zu erkennen, um die richtigen Narrative in die richtigen Netzwerkzentralitäten zu speisen.

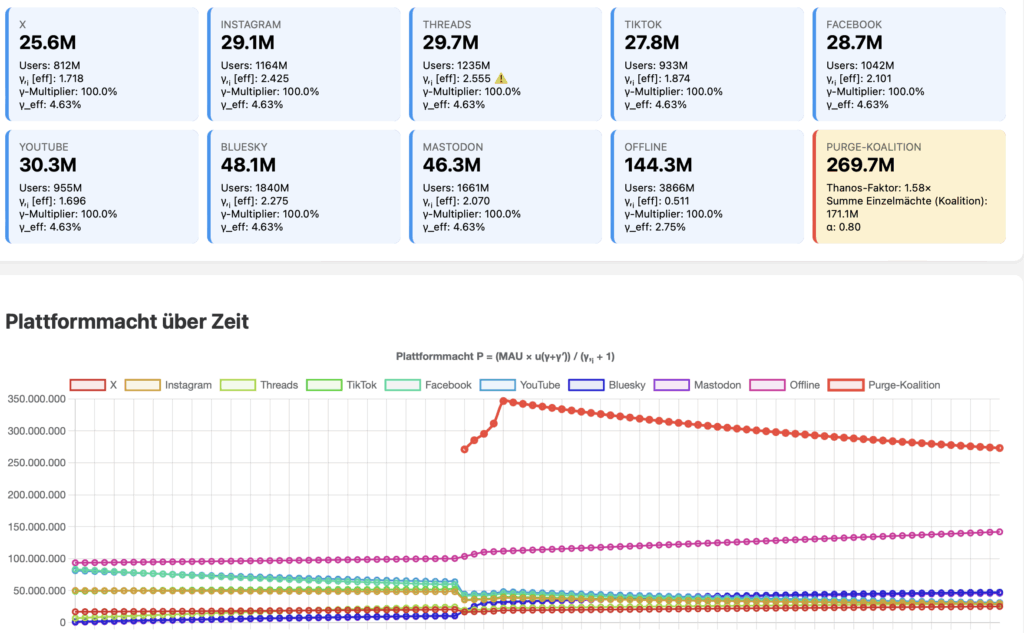

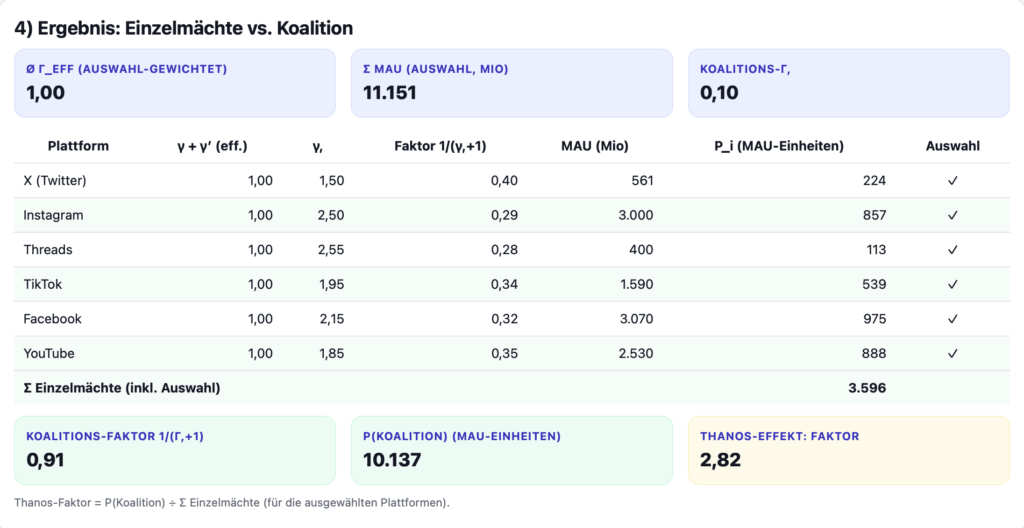

Aber vermutlich wird das nicht reichen, vor allem, wenn sich die Purge-Koalition materialisiert.

An Stelle der Demokraten würde ich das gesamte Werbegeld in den Aufbau eigener Medieninfrastrukturen investieren, um von den kommerziellen Plattformen unabhängige Kanäle aufzustellen.

Auch Isabella Weber schreibt begeistert über die Wahl von Zohran Mamdani als Bürgermeister von New York City.

Die Menschen sind so unzufrieden mit dem Status quo, dass sie alles außer Kontinuität wählen würden. Aber die Demokraten und die meisten demokratischen Parteien weltweit scheuen sich davor, echte Alternativen anzubieten. Das hat die Wähler in die Arme der extremen Rechten, ja sogar faschistischer Kräfte getrieben. Mamdani hat es sich zum Ziel gesetzt, deren Monopol auf Visionen für eine andere Zukunft zu brechen.

Mamdani konzentriert seine Kampagne darauf, das Leben wieder bezahlbar zu machen – und bietet damit Hoffnung. Er zeigt, dass demokratische Vertreter für die grundlegendsten materiellen Interessen ihrer Wähler eintreten können. Damit stellt er das Versprechen der Demokratie wieder her. Angesichts des weltweiten Vormarsches faschistischer Bewegungen bietet seine Kampagne etwas, das dringend benötigt wird: den Beginn eines antifaschistischen Wirtschaftsprogramms, mit dem Menschen zurückgewonnen werden können, die den Glauben an die Demokratie selbst verloren haben.Mamdanis Antwort ist bestechend einfach: Sicherstellen, dass sich alle New Yorker das Nötigste leisten können. Ein Mietpreisstopp für stabilisierte Wohnungen in Verbindung mit dem Bau von 200.000 neuen erschwinglichen Wohnungen. Kostenlose Busfahrten. Universelle Kinderbetreuung im Alter von sechs Wochen bis fünf Jahre. Pilotprogramme für städtische Lebensmittelgeschäfte in Lebensmittelwüsten. Höhere Steuern für Millionäre und Unternehmen, um all das zu finanzieren.

Was Weber hier sagt, ist nicht nur ihre Meinung, das ist auch Ergebnis ihrer Forschung.

Neue Untersuchungen, die ich zusammen mit Kollegen durchgeführt habe, zeigen, welche Preise für die Ungleichheit am wichtigsten sind. Wir haben festgestellt, dass eine kleine Gruppe von wesentlichen Sektoren – Energie, Lebensmittel und Landwirtschaft, Gesundheitswesen, Chemie, Wohnen und Großhandel – eine überproportionale Fähigkeit hat, bei Preisanstiegen Umverteilungen auszulösen.

Je ärmer man ist, desto mehr gibt man für Grundbedürfnisse aus. Wenn die Preise für lebenswichtige Güter steigen, sind die Auswirkungen der Inflation auf das unterste Einkommensdezil viel größer als auf das oberste Dezil. Ein Ölpreisschock trifft die ärmsten Amerikaner mit einem um 54 Prozent höheren Inflationsanstieg als die reichsten zehn Prozent. Bei landwirtschaftlichen Erzeugnissen und Lebensmitteln ist die Kluft mit 126 Prozent noch größer.

Diese Primärsektoren sind aber eben auch genau die Orte, wo man eine gerechte Preisstabilisierungspolitik ansetzen muss. Das hat Mamdani verstanden.

Die Gewährleistung erschwinglicher Preise für lebensnotwendige Güter, wie Mamdani verspricht, bekämpft Ungleichheit, ohne eine Gruppe gegen eine andere auszuspielen. Es gibt keinen Konflikt zwischen Arbeitslosen und Niedriglohnarbeitern, Menschen in Arbeiterberufen und unterbezahlten Fachkräften, verschiedenen ethnischen oder religiösen Gemeinschaften. Öffentliche Dienstleistungen wie kostenlose Busse und Kinderbetreuung sind für alle zugänglich. Das Konzept basiert auf Universalität statt Ausgrenzung – eine Wirtschaftsagenda, die Menschen vereint, anstatt sie in konkurrierende Gruppen zu spalten.

Öffentliche Optionen für lebensnotwendige Güter sind eine Form der Preisstabilisierung, von der alle profitieren, nicht nur die direkten Nutzer. Unsere Untersuchungen zeigen erhebliche Überschneidungen zwischen den Sektoren, die für Inflation und Ungleichheit am wichtigsten sind. Maßnahmen zur Verhinderung von Preisschocks in wichtigen Sektoren erfüllen eine doppelte Aufgabe: Sie begrenzen Inflationsrisiken und verhindern gleichzeitig einen plötzlichen Anstieg der Ungleichheit. Dies steht in direktem Gegensatz zur konventionellen Geldpolitik – der Anhebung der Zinssätze –, die die Ungleichheit durch höhere Schuldenkosten für die Armen und ein gedämpftes Lohnwachstum aktiv verschärft.

Genau deswegen halte ich es für so wichtig, sich Wirtschaft als Abhängigkeitsnetzwerk vorzustellen. Produkte, Services oder Ressourcen haben keinen Wert ansich, durch sie fließt Wert/Nutzen. „Nutzen“ empfinden wir in dem kurzen Moment, bei dem aus einer Sache, in Kombination unseres infrastrukturellen Kontextes und aus unserer jeweiligen Perspektive eine „Pfadgelegenheit“ entsteht.

Ich „will“ nicht diesen Schraubenzieher, ich will, dass die Spühlmaschine wieder läuft, damit ich meinen Abwasch machen kann, damit ich morgen aus dem Haus kann, ohne mir Gedanken zu machen, um dann auf die Arbeit zu fahren, um Geld zu verdienen, um mir einen Schraubenzieher kaufen zu können.

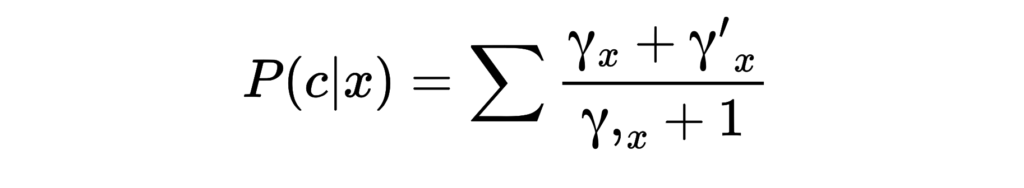

„Wert“ ist ganz grob gesprochen die Summe des erwarteten Nutzens einer Sache für jemandem in seinem spezifischen materiellen Kontext und seinem spezfischen semantischen Kontext – mit seinem spezifischen Wissen, seiner spezifischen kulturellen Prägung, seinen spezifischen Plänen, etc. Auf das Dividuum runtergebrochen ist es also eine Aggregation über alle von der Sache erwarteten Pfadgelegenheiten hinweg, geteilt durch die Pfadalternativen + 1. Das rechnet man natürlich nicht im Kopf aus, sondern imaginiert es, bis man es durch den Schmerz ihres Fehlens erfährt.

(Wir kennen die Formel bereits als unvollendete Plattformmachtformel und ich denke, sie passt ganz prima auf den „Wert“ von Dingen. Wert ist die Macht, die eine Sache über uns hat.)

Die Sache und damit ein Großteil des „Wert/Nutzen“ entsteht in einem anderen Netzwerk, den Pfad der Produktion, und dort über die gesamten dafür notwendigen Infrastrukturen hinweg, die den Schraubenzieher möglich und in der konkreten Situation nützlich machen und das inkludiert die lockere Schraube in der Spülmaschine, den Baumarkt, wo ich den Schraubenzieher gekauft habe, aber auch den Hersteller, den Zulieferer und deren Arbeiter*innen und deren Familienmitglieder, die den Haushalt schmeißen, ihre Wohnungen und ihren Warenkorb zum sattwerden, das Land, auf dem die Fabrik steht und das Land aus dem die nötigen Bodenschätze kommen und natürlich das Ökosystem, in dem all das eingebettet ist.

Aber dieses Netzwerk ist hierarchisch. Netzwerkknoten die weit unten liegen und sich schwer ersetzen lassen, haben einen überproportionalen Effekt auf alle nachgelagerten Pfadgelegenheiten. Wenn Energie teurer wird, ist die Übergangswahrscheinlichkeit auf andere Sektoren groß, denn Wohnen, die Produktion von Lebensmitteln und den ganze Rest der Pfadgelegenheiten ist stark von Energieflüssen abhängig. Dasselbe gilt etwas abgeschwächt für Lebensmittel und Wohnen. Werden die Grundbedürfnisse der Menschen teurer wird ihre Arbeit teurer, oder – wie es eigentlich läuft: Arbeiter*innen werden ärmer.

Ich habe dazu mit ChatGPT mal wieder ein Markowmodell gebaut, dass die wechselseitigen Anfälligkeiten der Sektoren für Schockweitergabe verdeutlicht: Es gibt vier Sektoren: Energie, Lebensmittel, Wohnen und Restwirtschaft deren Schocks man per Button auslösen kann (Erst Play drücken).

Die Schocks verbreiten sich dann entlang der abgebildeten Transitionsmatrix auf die anderen Sektoren und kühlen sich nach einiger Zeit wieder ab. Man kann das natürlich viel detaillierter und ausgefeilter konstruieren und gemessene Übergangswahrscheinlichkeiten einsetzen, wenn man die findet.

Das Paper, auf das Weber verweist ist ebenfalls interessant, Price Shocks are Redistribution Shocks.

Using the pre-pandemic sectoral price volatility and the price changes from early 2022 as the price shocks for our simulations, we show that a small set of sectors in energy, food and agriculture, healthcare, chemicals and, to a lesser extent, wholesale trade and housing, have a disproportionate capacity to increase inequality when their prices rise. […]

We have three main findings. First, we identify a small set of essential sectors—particularly in energy (e.g., Petroleum and coal products), agriculture and food (e.g., Farms, Food and beverage products), and healthcare (e.g., Hospitals, Ambulatory care services) but also in less obvious sectors like Chemical products and to a slightly lesser extent in Housing and Wholesale trade —as the most critical points of vulnerability that can exacerbate inequality. Second, we find that there is a large overlap between the sectors that are systemically significant for inflation and those that we identify as systemically significant for inequality. Third, we show that one simultaneous shock to all systemically significant sectors in 2022 has a direct effect on inequality equivalent to nearly one year of the average annual Gini increase during the neoliberal era (1980–2021).

Sie nennen das „pathways to systemic significance for inequality“ und formalisieren das so:

These specifications allow us to define what we call the pathways to systemic significance for inequality. That is, the potential of a sector to increase income inequality depends positively on:

- (1) The extent to which it is more important for the personal consumption of the poor than for the rich (direct channel).

- (2) The extent to which it is used more intensively as an input by goods that are relatively more important for the consumption of the poor than for the rich (indirect channel).

- (3) The magnitude of its price change, which in turn affects the magnitude of the inflation impact for each income group.

Auch Isabella Weber hat gelernt in Pfaden zu denken. Und das gilt auch für das, was sie „Übergewinne“ nennt.

There is one more reason why such a sectoral approach has the potential to prevent an increase in inequality: price spikes in systemically significant sectors for inflation can coordinate firms to hike prices across the economy in a process known as sellers’ inflation, which increases corporate profits and hence results in a functional redistribution of income from labor to capital (Weber et al., 2025; Weber & Wasner, 2023).

In previous work we devised an input-output simulation method to identify systemically significant sectors for inflation (Weber et al., 2024a; Weber et al., 2024b). We find that for the US, eight sectors have by far the greatest potential to trigger inflation when prices spike. These sectors are Petroleum and coal products, Oil and gas extraction, Utilities, Chemical products, Farms, Food and beverage and tobacco products, Housing and Wholesale trade. These are sectors that provide essentials for human livelihoods, essential inputs for production and essential infrastructure for the circulation of goods.

Wer im Nutzenpfad einer Sache Geld verdient, entscheidet nicht, wer den Wert konkret herstellt, sondern wer die netzwerkzentraleste Position im Abhängigkeitsnetzwerk seiner Herstellung und Vermarktung hat. (Ich bin immer noch nicht sicher, welches Maß an Netzwerkzentralität hier genau entscheidend ist. Seit ich alles konsequent in Pfaden zu denken versuche, tendiere ich zu einer Mischung aus Katz- und Current-Flow-Beweenness-Zentralität? Aber da würd ich gern mal mit nem richtigen Mathematiker drüber quatschen?)

Laufen viele Abhängigkeitlinien über deine Infrastruktur und gibt es im besten Fall auch nur wenige oder schlechtere alternative Pfade, kannst du es dir erlauben, Margen auf Kosten der anderen Netzwerkteilnehmer zu extrahieren. Von den Arbeiter*innen, klar, das hat Marx analysiert und weil Arbeiter*innen die am wenigsten netzwerkzentralen Einheiten im Nutzenfluss des Produktionspfads sind, d.h. am austauschbarsten sind, pressen die Oligarchen hier den Großteil ihrer Marge. Aber eben nicht nur? Wenn es die Abhängigkeiten hergeben, kommt die Marge eben auch auf Kosten von Zulieferern, Kund*innen, der eigenen Gesundheit, der Ökologie und über was man auch immer glaubt, genügend Macht zu besitzen.

Wir kennen diese Mechanismen vom „Monopol“ und mittlerweile hat man festgestellt, dass es auch ein Käufermonopol geben kann, aber „Monopsony“ und Monopol sind nur die unterdimensionalen Beschreibungen von Extremversionen dessen, wie der Kapitalismus funktioniert. Alle Akteure ringen miteinander um Netzwerkzentralität, denn wer Netzwerkzentralität hat, kassiert von den anderen Margen. Das heißt: Je mehr Wettbewerber, desto geringer die Macht der Unternehmen, desto kleiner die Margen. Auch abseits des Monopols lohnt es sich, Macht zu begrenzen.

Mit den Metaphern des „Marktes“ wurde die Macht in der Wirtschaft über Jahrzehnte verschleiert. „Der Markt“ sind drei Oligarchen im Trenchcoat, die zwar untereinander um ein bisschen um Einfluss konkurrieren, aber gemeinsam die „Choice Architecture“ aus Pfadgelegenheiten bereitstellen, die wir „Konsumfreiheit“ nennen und in der wir uns „frei“ bewegen dürfen – sofern wir es uns leisten können.

Der Preis, da hat die Neoklassik recht, ist der Ort, an dem sich der Pfad der Konsumption und der Pfad der Produktion/Vermarktung treffen, aber anders, als sie es sich denken.

Geld ist aus Usersicht eine universelle Pfadgelegenheit, eine art Joker-Pfadgelegenheit, die man in eine Vielzahl anderer Pfadgelegenheiten verwandeln kann. Und weil die meisten von uns zu Geld kommen, indem sie arbeiten, ist der Kapitalismus eine „Schmerzarchitektur„: Man geht so seiner Pfade und misst dabei den Wert der Pfadgelegenheiten aus dem Sortiment der einen Oligarchen am Schmerz ihres Fehlens und vergleicht ihn mit dem Schmerz, den es kostet, sich das Geld dafür bei einem anderen Oligarchen zu verdienen.

Weil nützliche Pfadgelegenheiten erst erwartet und dann zur Pfadabhängigkeit, bzw. Infrastruktur werden, besteht die Macht der Unternehmen gegenüber uns Konsument*innen in dem Potential, uns Schmerzen zuzufügen (planned Obsolescence, Preiserhöhung, Werbung, Shrinkflation, Enshittification, oder Beendung der Demokratie), ohne, dass wir das Abhängigkeitsverhältnis beenden.

Wenn Macht Netzwerkzentralität im Abhängigkeitsnetzwerk ist, dann bedeutet das aus Unternehmersicht, dass die Übergangswahrscheinlichkeit hoch ist, dass der Nutzenfluss durch die eigenen Infrastrukturen fließt. Supply-Schocks sind dann Ereignisse, die die Netzwerke verengen und damit die Macht einiger der Unternehmen erhöhen und ein Teil dieses Machtzuwachses setzen sie in steigende Preise, also in Margen auf Kosten der Konsument*innen, also in Übergewinnen um.

Man kann sich das Netz der Pfadgelegenheiten als eine riesige, komplexe, multidimensionale Landschaft mit Tälern und Schluchten vorstellen, die die wahrscheinlichen Pfade vorzeichnen, durch den der Nutzen entlang der infrastrukturellen Übergangswahrscheinlichkeiten pfadopportunistisch fließt und an dessen Engstellen sich Macht konzentriert und wo die Oligarchen ihre Schmerzkraftwerke betreiben.

Wenn wir den Oligarchen die Macht nehmen wollen, müssen wir ihnen ihre Netzwerkzentralität nehmen und das geht am besten, da hat Weber recht, indem wir die Pfadgelegenheiten aller Menschen erhöhen, durch Investition in möglichst freie und öffentliche Infrastrukturen und mit intelligenten Preiskontrollen bei pfadentscheidenden Primär-Gütern. Je mehr und bessere Alternativpfade angeboten werden, desto höher ist die Übergangswahrscheinlichkeit, dass die Menschen Oligarchmacht bypassen, was ihre Margenspielräume kollabieren lässt.

Ich nenne das die politische Ökonomie der Pfadgelegenheiten, oder auch: Kapitalismus aus Userperspektive. Aber ich bin auch mit Isabella Webers Begriff fine: antifaschistische Wirtschaftspolitik.