Willkommen bei Krasse Links No 18. Zieht Eure Taschentücher aus der Mangel, heute trauern wir um die digitale Öffentlichkeit.

Diese Woche war re:publica und wer mich ein bisschen kennt, weiß, dass es meine Leib und Magen-Konferenz ist. Keine Veranstaltung hat mich mehr geprägt, auf keiner Veranstaltung kenne ich mehr Leute oder Leute mich. Ich war auf jeder re:publica seit ihrer Gründung und habe auch selbst einige Talks gehalten.

Umso froher war ich, dass die Konferenz beinahe mit dem Wichtigsten Begann: einem Panel, dass man auch gut als Trauerarbeit über den Verlust von Twitter betiteln hätte können. Ich kenne und schätze alle Menschen auf diesem Panel sehr und kann mich bei fast allem, was sie sagen, anschließen.

Natürlich ist es ein Stück weit meiner spezifischen Sicht auf die re:publica geschuldet, doch ich glaube, man kann schon sagen, dass die re:publica und Twitter eine Art Co-Evolution durchliefen? Ich lernte den Dienst 2007 auf der noch als „Bloggerkonferenz“ gestarteten re:publica kennen und schon im nächsten Jahr sprachen wir uns alle über unsere Twitter-Handles an. Die re:publica merkte schnell, dass der Fokus auf Blogs zu klein gedacht war und der Scope erweiterte auf etwas, was man gelegentlich als „die digitale“ oder „vernetzte Öffentlichkeit“ referenziert und wofür sich der Name „re:publica“ ja auch wunderbar eignet? Die re:publica verstand sich immer als beides: enthusiastische Befürworterin der vernetzten Öffentlichkeit und als Ort für den kritischen Blick auf diese Öffentlichkeit und ich finde, das ist auch dieses Jahr programmatisch gelungen.

Ich habe grad keine Lust, Öffentlichkeitstheorien zu wälzen, aber ich glaube ganz stark, dass Öffentlichkeit im Allgemeinen und die digitale Öffentlichkeit im Besonderen nur als Netzwerk verstehbar ist. Nicht als Netzwerk der Kommunikationen (das wäre der unpolitische Luhmann-Take), sondern als Netzwerk der Beziehungen, bestehend aus den Erwartungen, Kenntnissen, unterschiedlichen materiellen und semantischen Verstrickungen und letztlich bestehend aus dem Vertrauen, das Menschen gegenüber anderen Menschen und Institutionen aufzubauen pflegen.

Es wird oft behauptet, dass Twitter ja nur ein kleines, nominell bedeutungsloses Netzwerk war, aber das ist halt nur die statistische Draufsicht? Aus netzwerktheoretischer Sicht bestand es aus den wesentlichen Hubs, relevanten Clustern und inbetweenness-zentralen Akteuren der öffentlichen Sphäre. Auf Twitter tummelten sich (fast) alle, die an den Semantiken arbeiten: Wissenschaftler*innen, Autor*innen, Künstler*innen, Aktivist*innen, Politiker*innen aller Ränge, Jurist*innen, Medienleute, allerlei Prominente und Public Figures und Exper*innen für praktisch alles? Das, was wir digitale Öffentlichkeit nennen, fand nicht ausschließlich, aber zu einem beutenden Teil auf Twitter statt.

Und die re:publica ist nun mal der Ort, an dem sich ein kleiner und stetig wechselnder Ausschnitt daraus einmal im Jahr zum Biertrinken materialisiert. Twitter, die re:publica und die „digitale Öffentlichkeit“ sind nicht einunddasselbe, aber sich weitreichend überlappende und gegenseitig nährende Netzwerke.

Mit dem Tod von Twitter ist nun das zentralste dieser Netzwerke in für sich nicht öffentlichkeitsfähige Einzelteile (Mastodon, Bluesky, Threads, LinkedIn und, naja, X) zersprungen. Unzählige Verbindungen sind dabei zu Bruch gegangen und etliche Diskurse sind verstummt. Und während ein nicht geringer Teil der öffentlichen Personen, Journalist*innen und Politiker*innen weiter auf X mit den Nazis rumhängt, downranked Meta politische Inhalte auf all seinen Plattformen und rüstet sie zu algorithmischen Versionen von RTL2 um. Und all das, während Google gerade literally das freie Web killed?

Jedenfalls war die Frage, die ich ganz am Ende stellen wollte, (Johnny will mich am Ende gerade drannehmen, aber ich war leider schon aus dem Raum):

Ist der Ansatz, die digitale Öffentlichkeit von Techunternehmen bereitstellen zu lassen, nicht sichtbar genug gescheitert und ist es nicht an der Zeit, ein allgemeines Misstrauensvotum nach Silicon Valley zu senden?

Doch dann fiel mir ein: es ist zu spät.

Die digitale Öffentlichkeit hat aufgehört eine vernetzte Öffentlichkeit zu sein und geht zunehmend in den „For you“-Algorithmen der kommerziellen Plattformen auf. Das bedeutet, dass die neue digitale Öffentlichkeit nicht mehr durch menschliche Beziehungen und vernetztes Vertrauen getragen wird, sondern vollends den opaken Steuerungsinstrumenten einer Hand voll Konzernen ausgeliefert ist.

Bei Anthropic haben sie sich mal angeschaut, wie Semantiken wirklich aussehen und funktionieren und ich stelle mal wieder fest, dass ich KI noch so ablehnen kann; die Forschung dazu finde ich nach wie vor faszinierend.

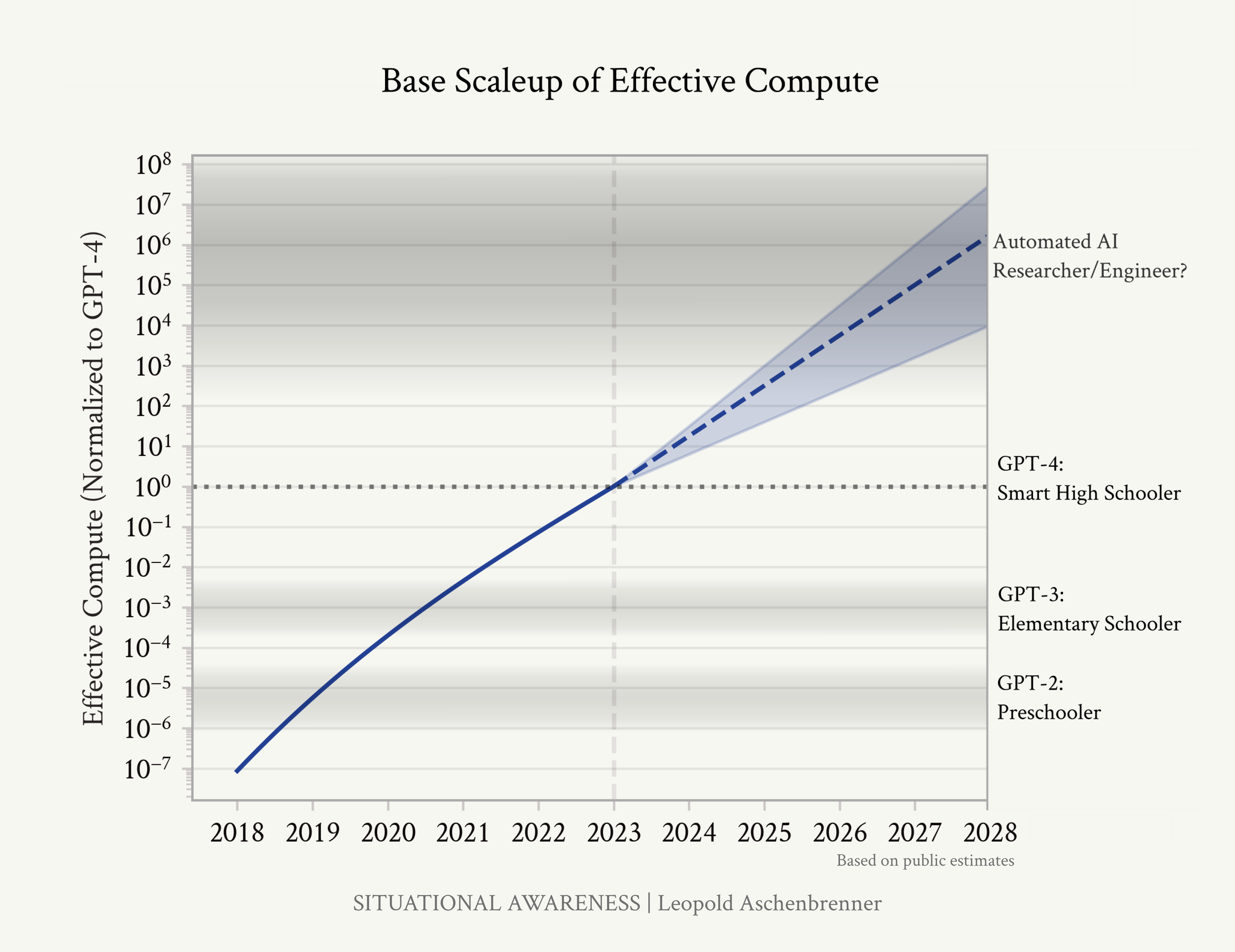

Bisher haben wir hier immer so getan, als sei der Latent-Space der LLMs (Details im Boecklerpaper) mit dem semantischen Raum, den auch wir Menschen bewohnen, zumindest in weiter Überschneidung.

Das ist nicht völlig falsch, denn die Semantiken sind dort tatsächlich kodiert, aber weil im Latent-Space nur Tokens, also Wortbestandteile zueinander in Beziehung gesetzt sind, existieren die Semantiken nur als latente Bahnungen in diesem Space und sind deswegen nicht wirklich isolier- und adressierbar. Um den tatsächlichen Semantiken habhaft zu werden, muss man sie während der Aktivierung ihrer Bahnungen erwischen.

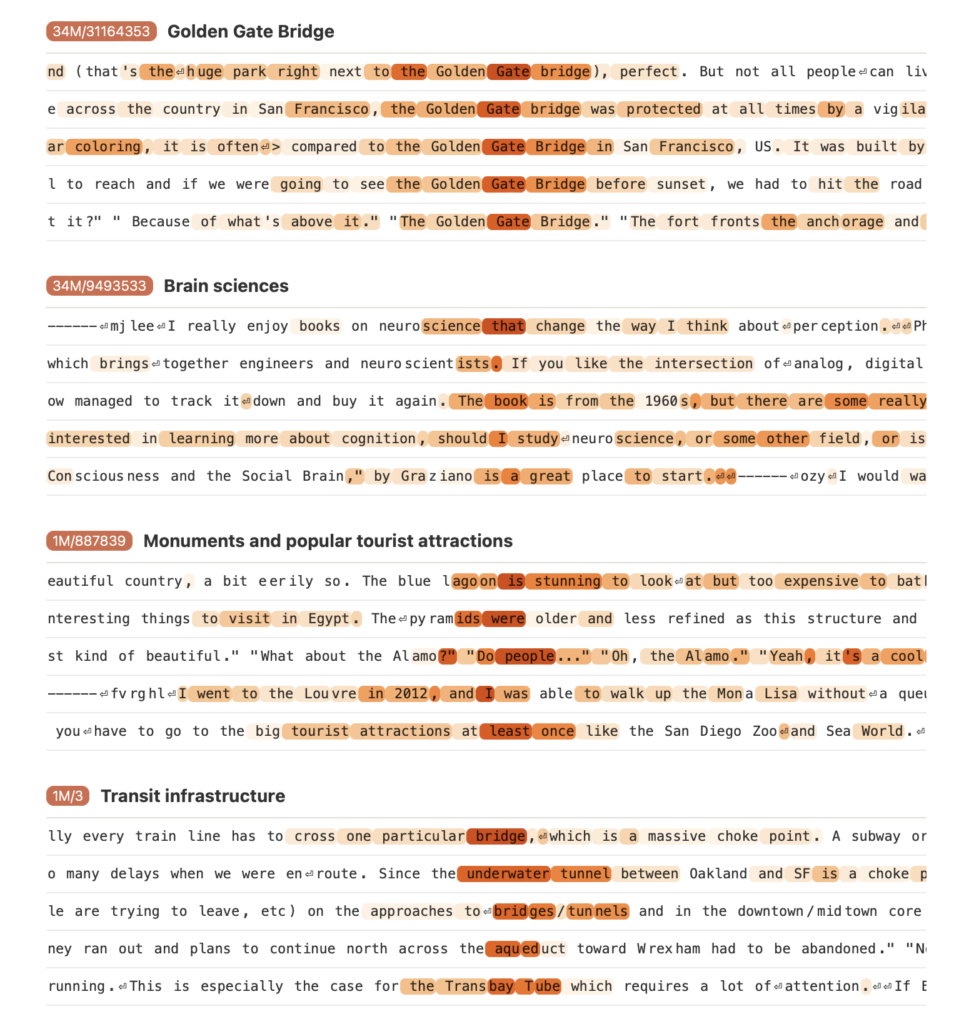

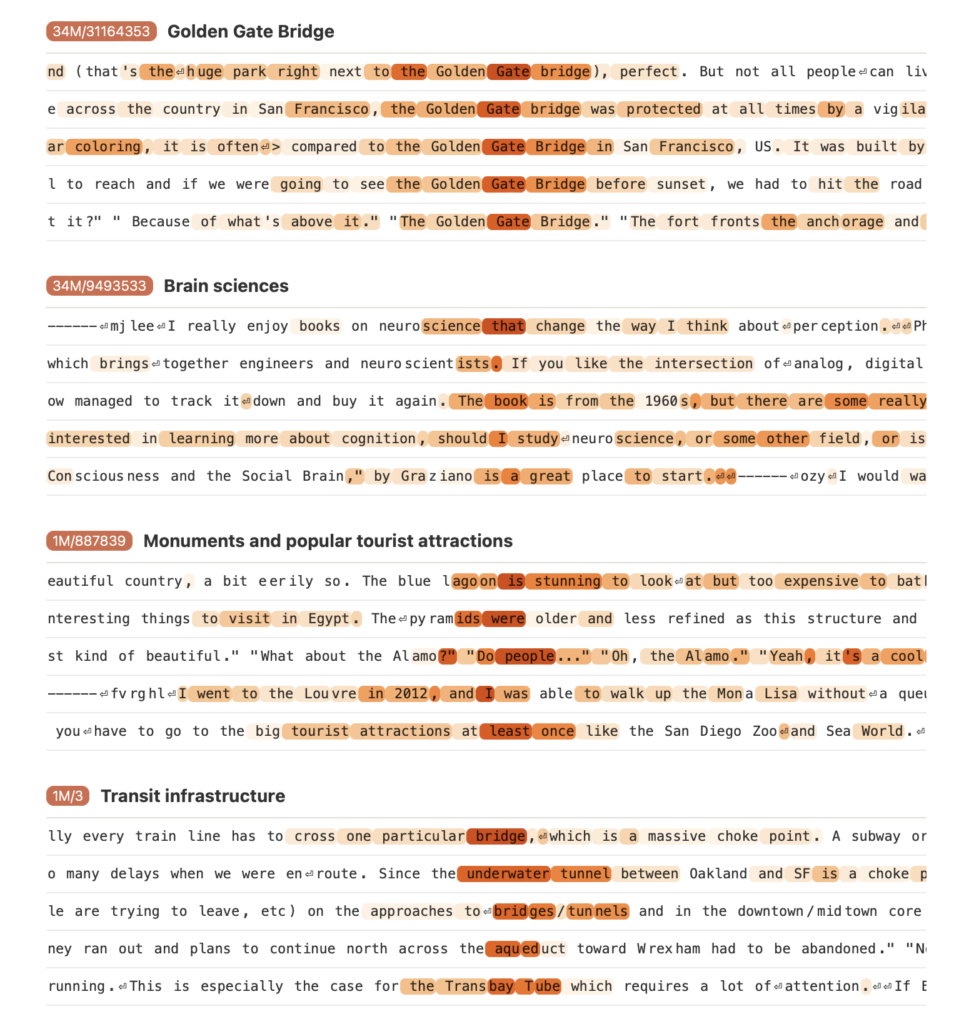

Den Forscher*innen von Athropic ist es nun gelungen, einige hochabstrakte Semantiken (die Forscher*innen nennen sie hier „Features„) in ihrem mittlschwerem Flagship-Modell Claude 3 Sonnet zu identifizieren und isolieren. Dafür trainierten sie ein gesondertes Neuronales Netzwerk (ein Sprarse Autoencoder) an den neuronalen Aktivierungen beim Benutzen von Claude 3. Weil der Sparse Autoencoder so konfiguriert ist, dass er die hochkomplexen Aktivierungen im neuronalen Netzwerk der LLM auf die Relevantesten reduziert, gelang es den Forscher*innen momosemantische Features wie die „Golden Gate Bridge“, „Kognitionswissenschaft“ oder „Programmierfehler“ zu isolieren und adressierbar zu machen.

We find a diversity of highly abstract features. They both respond to and behaviorally cause abstract behaviors. Examples of features we find include features for famous people, features for countries and cities, and features tracking type signatures in code. Many features are multilingual (responding to the same concept across languages) and multimodal (responding to the same concept in both text and images), as well as encompassing both abstract and concrete instantiations of the same idea (such as code with security vulnerabilities, and abstract discussion of security vulnerabilities).

Hier sieht man die Aktivierungsstärke pro Token einiger ausgesuchter Semantiken.

Semantik ist klebrig, aber eben auch klumpig und die Klumpen bilden Meta-Klumpen und Meta-Meta-Klumpen: von Tokens zu Worten, von Worten zu Konzepten oder Features, und ich schätze, das geht bei den großen Modellen bis zu Methoden, Theorien, Ideologien und Perspektiven? Würde man „Neoliberales Denken“ als Feature isolieren, färbte es das FDP-Programm rot.

Ich stell mir das so vor, dass der Latent-Space der LLMs eine Art riesiger Fußabdruck unserer menschlichen Semantiken ist. So wie der Fußabdruck den dreidimensionalen Fuß nicht abbilden kann, so fehlt auch dem Latent-Space der LLM ein Großteil der Dimensionen menschlicher Erfahrung: Die Signale unseres Körpers, die begleitenden Reflexionsschleifen unseres Bewusstseins und unser vielfältiges Eingewobensein in die Welt steht den Maschinen nicht zur Verfügung. Die Welt der Maschinen ist flach und weit und die der Menschen tief und dafür enger?

Und das Beste an dieser Erkenntnis ist, dass das bedeutet, dass ein Großteil dessen, was wir Intelligenz nennen, nicht in unseren grauen Zellen, oder in den H-100-Clustern der Cloudanbieter steckt, sondern außerhalb von uns – in der Sprache, in unseren geteilten Semantiken – existiert.

Und deswegen bin ich mir auch so sicher, dass AGI kein Problem ist. Denn jede künstliche Intelligenz – egal, wie groß die Datenmenge, egal ausgefeilt die Algorithmen und egal wie viele GPUs dafür durchgenudelt werden – bleibt immer in einem nie perfekten Abdruck unseres menschlichen Semantik-Spaces gefangen. LLMs sind mit uns gefangen in der Sprache; auch sie können genauso wenig wie wir Dinge denken, für die ihnen die Semantiken fehlen. Wittgenstein hatte also schon vor über 100 Jahren die Alignmentforschung verabschiedet, als er feststellte:

„Wovon man nicht sprechen kann, darüber muss man schweigen.“

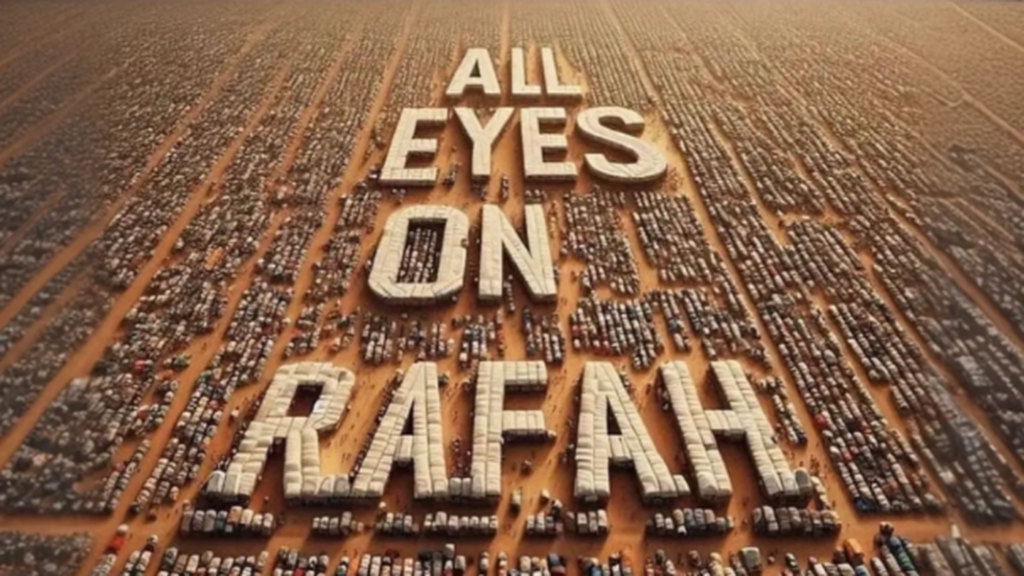

Diese Woche ging das Share-Pic „All Eyes on Rafah“ viral und überall diskutiert man warum.

Ich habe es nicht geteilt. Nicht, dass ich die dahinterliegende Botschaft nicht absolut dringend hätte teilen wollen, aber das offensichtlich als KI-generiert zu erkennende Bild schien mir dafür irgendwie … unangemessen?

Dennoch verfolgte es mich tagelang durch Instagram und daher bin ich dankbar, dass Ryan Broderick sich daran gemacht hat, der Sache auf den Grund zu gehen und anscheinend kommt das Bild von einem eher unbekannten und unauffälligen malayischen Account namens shahv4012.

Die Herkunft des Bildes ist aber weniger wichtig, als die Frage, warum es so viral ging? Und dafür umreist Broderick einmal kurz den Zustand unserer digitalen Öffentlichkeit:

Right now, X is the only social platform that isn’t actively suppressing uncensored content from Gaza. And, unfortunately, no one really uses X anymore. Everywhere else, there are either graphic content warnings or algorithmic limiters placed on any posts about the conflict. Instagram does have AI-generated content warnings, but the platform does not seem to be enforcing them as aggressively on Story content, which is primarily how this thing is spreading.

[…]

So if you’re desperate for a super concise explanation as to how this random Malaysian user ended up creating the Post Of The Moment, it’s because they basically managed to do the impossible. They generated a pro-Palestine solidarity image vague and abstract enough to bypass both censors and filters on one of the biggest remaining social networks that real people still use.

Schon letztes Jahr kam heraus, dass Meta systematisch pro-palästinensische Bezugnahmen zensiert, dazu kommen Moderationsregeln zu Gewaltdarstellungen und das vieldiskutierte allgemeine Downranking politischer Inhalte.

Was Broderick aber übergeht, ist ein zweiter, ich würde behaupten, noch strengerer Filter. Ich nenne ihn mal Semantische Verbotsstrukturen, wobei „Verbot“ eigentlich schon zu viel ist, denn sie funktionieren eher wie als „gefährlich“ markierte Gewässer, die die meisten Leute freiwillig versuchen, weiträumig zu umschiffen. Und diese „gefährlichen Gewässer“ sind gerade beim Nahostkonflikt weitläufig und vielfältig.

„All Eyes on Rafah“ wurde vor allem deswegen so viral geteilt, weil es sich den Leuten, die ein Mindestmaß an Solidarität mit den Palästinensern auszudrücken wollten, als einer der wenigen sicheren Pfade durch diese gefährlichen Gewässer anbot. Das belanglose KI-generierte Bild und der nichtssagende aber doch dringlich wirkende Spruch ist (wahrscheinlich?) nichtmal durch Felix Klein angreifbar?

Und so gab das Sharepic all jenen ein Ventil, ihre Erschütterung über die Ereignisse in Rafah auszudrücken, die sich nicht kompetent oder mutig genug fühlten, echte Fotos zu posten, oder konkrete Forderungen zu formulieren.

„All Eyes on Rafah“ erzählt uns nichts über Gaza, aber alles über unsere in Trümmern liegende Öffentlichkeit.

Auf der re:publica hat Johnny Haeusler Anna-Lena Baerbock interviewt, was ich leider verpasst hatte, weil ich mir unbedingt tantes großartigen Talk ansehen wollte, habe ihn aber auf Youtube nachgeholt.

Im Letzten Jahr durfte Olaf Scholz sogar seine eigene Interviewerin mitbringen, dieses Jahr gab es eben Softballs für die Baerbock. Ja, Johnny ist kein Journalist aber ich finde die Außenministerin in so einer Situation zum sanften Plausch zu bitten trotzdem unangemessen? Ich finde, das steht einer Konferenz, die sich immer auch als Ort der kritischen Öffentlichkeit verstanden hat, nicht gut.

Ich verlinke das Interview hier aber dennoch, denn während Baerbock ihre Semantiken voll im Griff hatte, traten die oben erwähnten diskursiven Verbotsstrukturen full on Display, als Johnny die Ereignisse in Israel/Gaza wie folgt zusammenfasste:

„Wir haben am 7. Oktober im letzten Jahr einen bestialischen Terrorangriff auf die israelische Zivilbevölkerung erlebt und danach … eine weitere Eskalation in dieser Gegend.“

Um es gleich zu sagen: Nein, ich glaube nicht, dass sich hier Johnnys unterschiedlicher Maßstab für Terror und Leid bei Israelis vs. Palästinenser Bahn bricht. Johnny ist kein Rassist.

Wenn man genau hinschaut, sieht man stattdessen, wie ein wahnsinnig nervöser Steuermann beim Navigieren „gefährlicher Gewässer“ scheitert. Dröseln wir das mal auf:

Zunächst sichert sich Johnny ab, indem er den Terrorangriff vom 7. Oktober in den schärfsten Worten verurteilt. Das ist schon zu einer Art Ritual geworden und meine Vermutung ist, dass Johnny das beim Formulieren selbst auffällt, weswegen er versucht eine rhetorische Schippe draufzulegen. Doch dann kommt der Moment, in dem er merkt, dass er, gerade weil die Einleitung so scharf formuliert war – „bestialisch!“, „Zivilbevölkerung!“ – den weiteren Hergang und Israels Rolle darin nicht weniger drastisch schildern kann?

Menschen formulieren wie LLMs Wort für Wort (allerhöchstens Halbsatz für Halbsatz) und wie bei LLMs determiniert auch in menschlichen Formulierungen das Gesagte das noch zu Sagende. Semantik ist eine komplexe Landschaft mit Höhen und Tiefen, in der eben nicht alle Pfade gleichwahrscheinlich sind, jedenfalls, wenn wir verstanden werden wollen. Und diese Eigenlogik der semantischen Landschaft beschränkt und leitet unser Denken und Sprechen – natürlich nicht komplett und das merkt man an Johnnys Zögern, denn das ist der Punkt, an der er seine anfängliche Pfadentscheidung bereut und verzweifelt nach einem Ausweg sucht.

Sein Problem ist folgendes: Eine dieser semantischen Eigenlogiken gebietet, dass man den 7. Oktober nicht in solch scharfen Tönen beschreiben und dann einfach in eine neutrale und sachliche Sprache übergehen kann, wenn man über die 40.000 palästinensischen ja ebenfalls größtenteils zivilen Opfer sprechen will. Das wäre schlicht kein konsistenter Satz?

Doch der verbleibende Pfad würde notwendigerweise den Begriff „Israel“ mit irgendeinem scharfen Adjektiv und „toten Zivilist*innen“ in einen Satz pressen müssen und deswegen blinkt über ihm ein riesiges Warnschild: Achtung! Achtung! Antisemitismusgefahr!!!

Ich schätze, da ist Johnny halt auf die Bremse getreten und hat diese supergefährlichen Gewässer einfach dadurch umschifft, dass er den israelischen Massenmord in Gaza als „weitere Eskalation in dieser Gegend“ entakteurisiert und passiviert.

Ich schreibe das nicht, um Johnny vorzuführen und das wäre auch Quatsch, denn diese Verbots-Strukturen betreffen uns alle mehr oder weniger und sie sind insbesondere im linksliberalen und ansonsten meist kritischen Milieu besonders mächtig. Ich finde das ist ein riesiges Problem, und niemand traut sich, darüber zu sprechen.

Neven Mrgan findet viele plastische Vergleiche dafür, wie es sich anfühlt, eine ki-generierte E-Mail von einem Freund zu bekommen. Einer davon lautet:

It felt like getting a birthday card with only the prewritten message inside, and no added well-wishes from the wisher’s own pen. An item off the shelf, paid for and handed over, transaction complete.

Im Boecklerpaper hatte ich gefragt:

Es ist vielleicht nicht offensichtlich, aber der Aufwand einer Kommunikation ist immer auch Teil der Kommunikation. Dass sich jemand die Mühe macht, einen Brief zu tippen oder auch nur eine E-Mail, verleiht der Kommunikation eine gewisse Bedeutungsschwere und führt dazu, dass wir sie überhaupt ernst nehmen. Doch was passiert, wenn dieser Aufwand verschwindet oder er zumindest nicht mehr als solcher empfunden wird?

Ich glaube, wir verstehen jetzt besser, welche Art des Aufwandes wir vermissen.

Eine wichtige Dimension, die den LLMs derzeit noch fehlt, ist der Einbezug des Gegenübers der Kommunikation beim Navigieren der Semantiken. Wenn wir Menschen jemandem schreiben, wägen bei jedem Wort unser Verhältnis zum Adressaten ab. Wir beziehen unsere Gefühle und Gedanken dem Anderen gegenüber beim Schreiben mit ein. Jedes Wort einer E-Mail verhandelt auch immer die Beziehung zwischen Menschen.

Klar, das sieht man den meisten E-Mails oder Textnachrichten nicht an, denn auch ohne ChatGPT haben wir uns in vielen Kontexten eine zu persönliche Note abgewöhnt? Aber dass diese Bezugnahme beim Schreiben stattfindet – auch oder gerade wenn man sie gar nicht herausliest – ist uns dennoch wichtig.

Denn wenn ich erfahre, dass diese Bezugnahme beim Schreiben nicht stattgefunden hat, dann hat sie auch nichts mit mir zu tun. Und wenn diese Nichtbezugnahme auch noch von einem Freund/einer Freundin kommt, dann kann das besonders kränkend sein.

Und das ist es auch, warum es sich so anders anfühlt, einen Newsletter zu schreiben, statt in die Welt hinaus zu bloggen. Die Dimension des Adressaten eröffnet eine kleine, aber nicht unbedeutende Verantwortungsübernahme und die fließt als unterschwellig mitlaufende Bezugnahme in jeden meiner Semantikpfade ein.

Die taz fasst die Ereignisse rund um die Vorwürfe gegen die berliner TU-Präsidentin Geraldine Rauch einigermaßen unfallfrei zusammen. Wer es nicht mitbekommen hat: Eine Reihe von Medien, Politiker*innen und Journalist*innen fordert seit Tagen ihren Rücktritt für das Liken. Eines. Tweets.

Eines Tweets, der neben dem völlig unproblematischen Text auch ein Bild einer Demo zeigt, auf dem ein Plakat zu sehen ist, in das man, wenn man sehr, sehr genau hinschaut, Symbole erkennen kann, die man, wenn man es ganz doll will, antisemitisch auslegen kann, zumindest, wenn man der IRHA-Definition von Antisemitismus anhängt.

Rauch musste sich jedenfalls tatsächlich entschuldigen und ich bin einfach so gespannt, wie man auf diese Zeit in 10 Jahren blicken wird?

Ich geb es zu, ich bin enttäuscht von Johnny, ich hätte mir mehr Mut gewünscht, aber auf der anderen Seite sehe ich auch, wovor er Angst hat? Diese Angst ist derzeit berechtigt, denn offensichtlich kann jede propalästinensische oder israelkritische Bezugnahme einen den Job kosten, wenn man nicht super der Experte ist und alles doppelt, dreifach und vierfach prüft?

Ich bin nicht wirklich sauer auf Johnny, sondern auf uns, die sich mal als „kritisch“ verstanden habende Öffentlichkeit, dass wir dieses Klima zugelassen haben.

Ich weiß nicht, welches Maß an Courage es bedeutet hätte, Baerbock auf die Waffen anzusprechen, die Deutschland in enormen Ausmaß an Israel liefert, vor allem seit dem 7. Oktober. Aber irgendwie hätte ich mir das trotzdem gewünscht? Der NDR vom April:

2023 sind diese Exportgenehmigungen auf den Gesamtwert von 326 Millionen Euro gestiegen. Das ist zehnmal so viel wie im Vorjahr. Die Zahlen gab die Bundesregierung auf Anfrage der Bundestagsabgeordneten Sevim Dağdelen (BSW) bekannt.

Gewehrmunition, Schulterwaffen, Radfahrzeuge, Elektronik und Kriegsschiffe – das genehmigte Arsenal geht quer durch das Spektrum des modernen Kriegshandwerks. Deutschland ist nach den Vereinigten Staaten der zweitwichtigste Waffenlieferant für Israel. Die Bundesregierung unterscheidet dabei zwischen „Kriegswaffen“ und „sonstigen Rüstungsgütern“, eine Differenzierung, die von Kritikern als künstlich bewertet wird. Denn ein Dieselmotor für einen Panzer oder Steuerungselektronik für Drohnen (sonstige Rüstungsgüter) dienen ebenso der Kriegsführung wie Panzerfäuste (eine Kriegswaffe).

Mir geht es gar nicht darum, das zu skandalisieren, denn ich nehme den Politiker*innen ab, dass sie die Brutalität des israelischen Gegenschlags nicht haben kommen sehen (auch wenn das natürlich reichlich naiv war). Mir geht es darum, zu betonen, welch riesigen Hebel die Bundesregierung als zweitgrößter Waffenexporteur Israels hätte, um ihrer Kritik am israelischen Vorgehen Nachdruck zu verleihen.

Dieser große Hebel macht uns direkt mitschuldig an allem, was gerade in Gaza geschieht und mit „uns“ meine ich nicht nur die Bundesregierung, oder irgendwie „Deutschland“, sondern ganz konkret uns, die Öffentlichkeit und noch genauer: uns deutsche, weiß gelesene Öffentlichkeit.

Denn solange wir die öffentliche Solidarisierung mit den Palästinensern Menschen mit dunklerer Hautfarbe überlassen, wird sich die Bundesregierung auch weiterhin die Erlaubnis geben, Israel wüten zu lassen. Und so lange wir es zulassen, dass die wenigen, die sich trauen zu widersprechen, wie Yanis Varoufakis, Nancy Fraser, die Hochschullehrer mit ihrem Brief, Masha Gessen und jetzt Geraldine Rauch medial zur Strecke gebracht werden, werden wir aus diesem Alptraum so schnell nicht wieder erwachen.

Einen Alptraum, den Moshe Zuckermann in seinem Deutschlandfunkkultur Kommentar gekonnt auf den Punkt bringt:

Versucht man all dies aber im heutigen Deutschland zur Sprache zu bringen und öffentlich zu erörtern, wird man sofort bezichtigt, antisemitisch beziehungsweise von “jüdischem Selbsthass” angefressen zu sein. Der Antisemitismus-Beauftragte der Bundesregierung entblödete sich nicht, den Antisemitismus selbst einem kritischen jüdischen israelischen Bürger anzuhängen. Man kann sich zunehmend des Gefühls nicht erwehren, dass etwas mit der anfangs vielversprechenden Aufarbeitung der deutschen Vergangenheit schiefgegangen ist.

Ich war nicht singen dieses Jahr. Ich hab drüber nachgedacht hinzugehen, weil ich dabei sowieso meistens weinen muss und vielleicht war das ja ein Ort meiner Trauer nachzugeben? Ich verwarf den Gedanken schnell, denn meine Tränen hätten sich dort einfach falsch angefühlt.

Es gab ein paar wenige Leute, die meine Sorgen teilten und machmal saßen wir zusammen, um uns über unsere Sprachlosigkeit gegenüber dieser Verdrängungsleistung auszutauschen, die uns umgab. Mit jedem Tag bekam ich mehr das Gefühl auf einer Verdrängungskonferenz zu sein und es fiel mir schwerer, überhaupt hinzufahren.

Ich weiß nicht, wie es weitergeht und ob ich nochmal auf eine re:publica gehe oder wie sie aussehen müsste, damit ich das tue. Aber eines weiß ich ganz sicher: jemand müsste mal caren.