Willkommen bei Krasse Links No. 6. Anschnallen, wir müssen heute über politische Ökonomie und KI sprechen.

Für diejenigen unter euch, die nicht sofort wissen, was politische Ökonomie ist, hier die Ultrakurzfassung: Während die klassische Ökonomie das wirtschaftliche Geschehen vom Markt her analysiert, interessiert sich die politische Ökonomie für die Machtverhältnisse hinter den Markttransaktionen (Langfassung).

Phänomene wie Enshittification lassen sich mit neoklassischer Wirtschaftstheorie kaum, mit politischer Ökonomie jedoch prima erklären. Kevin Carson hat genau das in einem lesenswerten, aber ultralangen Aufsatz gemacht. Er will aber auf einen breiteren Punkt hinaus: die allgemeine Ausweitung dessen, was Ökonom*innen „Rente“ nennen, bis zu dem Punkt, dass einige bereits von einem neuen Feudalismus sprechen. Renten sind Einkommen, denen keine notwendige Arbeit oder sonstige Kosten gegenüberstehen, weil sie sich aus dem Besitz von rechtlichen Titeln oder sonstigen Machtpositionen heraus ergeben. Vielen Techunternehmen wird vorgeworfen, dass ihren Geschäftsmodellen das Abgreifen von Renten zugrunde liegt. Man denke nur an Apples 30% Abgabe im App Store. (In meinem Plattformbuch gehe ich einen Schritt weiter und nenne die durch Enshittification erzwungenen Renten „kommerziellen Vandalismus“, vgl. S. 328.)

Carson dröselt die Rentenfrage weiter auf und zeigt, dass sie nicht auf den Techsektor beschränkt ist, sondern dass Renten in vielen Branchen einen großen Teil des verdienten Geldes ausmachen. Geld, das sich in den Taschen von immer weniger Unternehmen und Individuen konzentriert.

Aus Sicht der politischen Ökonomie wirkt der aktuelle Moment im Kapitalismus wie ein riesiger Heist von einigen wenigen am Rest der Gesellschaft und die neoklassische Ökonomie mit ihrer verharmlosenden Markterzählung dient ihnen als Coverstory.

Letzte Woche fand die Elevate Konferenz statt und Nick Srniceks Keynote über die politische Ökonomie von KI ist sehenswert.

Srniceks zieht in den KI-Markt vier Ebenen ein:

Srniceks zieht in den KI-Markt vier Ebenen ein:

- Apps (ChatGPT, Autopilot, etc.)

- Modelle (also GPT4, Gemini 1.5 und Claude 3)

- Infrastruktur (Cloudinfrastruktur zum Training und Betrieb der Modelle)

- Hardware (Grafikkarten und KI-Chips)

Seine These ist nun, dass der Infrastrukturlayer – also Google, Amazon und Microsoft – derart dominant wird, dass er sich mittelfristig alle anderen Ebenen einverleiben wird.

Eine Ebene lässt Srnicek aber aus. Unterhalb des Hardwarelayers (wenn man darin die konkreten Chipdesigns fassen möchte) liegt noch der Chipproduktionslayer und wir wissen ja, dass da ebenfalls ein krasser Flaschenhals steckt. Noch letztes Jahr produzierte das Taiwanesischen Unternehmen TSMC 90% aller Highend-Chips und so könnten die Bemühungen der großen Techunternehmen, ihre Abhängigkeit von Nvidia zu reduzieren, indem sie eigene KI-spezifische Microchips entwickeln, nur in andere Abhängigkeiten führen.

Die Financial Times hat ein erklärbärig illustriertes Feature veröffentlicht, das detailliert durch die Prozesse zur Herstellung von modernen Microchips führt.

Bei dem vielen Geld, Talent und Ressourcen, die gerade in KI gesteckt werden, ist zu erwarten, dass wir tatsächlich dabei sind in eine neue digitale Ära schliddern. Ben Wertmüller hat sich dort schon mal umgesehen, indem er den KI-basierten Arc Search Browser getestet hat.

Statt einer Linkliste mit etlichen Quellen bekommt man bei Arc nur noch eine Antwort. Arc zieht im Hintergrund die Informationen aus den Inhalten anderer Websites zusammen und präsentiert sie als wikipedia-artig strukturiertes Dossier – ja, auch mit Quellenangaben. In Wertmüllers Test lag Arc LLM-typisch zwar immer wieder auch komplett daneben, dennoch lässt es als ein slickes Produkt der nahen Zukunft imaginieren – wenn man vergisst, was es ersetzen soll.

I guess what I’m saying is: thanks, I hate it. Give me context; give me nuance; give me the ability to think for myself. We built the world’s most incredible communication and knowledge-sharing medium, rich with diverse perspectives and alternative ideas; let’s not sanitize it through a banal filter that is designed to strip it of its humanity.

Das Web plus Google bildeten gemeinsam ein atmendes, sich stetig tiefer verzweigendes und dennoch einigermaßen navigierbares soziotechnisches Archiv des Weltwissens, bestehend aus menschlichen Perspektiven, die man in Form von Dokumenten durchstöbern, kritisch begutachten und einordnen muss und deren Informationsreichtum sich niemals auf die gestellte Frage reduziert. Ich glaube, dass uns manchmal gar nicht genug bewusst ist, wie kostbar das ist … war?

Das führt uns zu der zugegeben naheliegenden These, dass generative KI vor allem hier ist, um das Internet zu ersetzen. Oder wie es Henry Farrel in seinem Blogpost elegant auf die Formel bringt: The map is eating the Territory.

Ich mag auch seine Kategorie der „kulturellen Technologien“, zu denen er so abstrakte Wirkzusammenhänge wie Märkte, Regierungen und Unternehmen zählt. Generative KI sei eben eine weitere „kulturelle Technologie“ und stehe somit im Spannungsfeld zu den etablierten Platzhirschen. Die weitere Analyse dreht sich somit um die Frage, ob und wie es KI gelingt, sich Wirkungsbereiche und Kompetenzfelder der anderen kulturellen Technologien einzuverleiben.

Angewandt auf den Streit um das Urheberrecht kommt Farrel schließlich auf die These, dass es bei den aktuellen Gerichtsverfahren (etwa New York Times vs. OpenAI) eben nicht um moralische oder gar gesellschaftliche Fragen geht, sondern dass hier das alte und das neue Regime um Macht ringen.

Das geht schon in die richtige Richtung, aber ich würde noch weiter gehen. Bereits beim Plattformparadigma (das ich übrigens auch als „kulturelle Technologie“ im obigen Sinne einordnen würde) diente das Urheberrecht vor allem der Erlangung und Konsolidierung von Machtpositionen über nicht subsitutierbare kulturelle Graphen (genauso wie Patente für technische Graphen). Am plakativsten lies sich das in den Streaming-Wars beobachten: Die Hinwendung der Streamingdienste zu endlos erweiterbaren Francieses wie Star Wars, Lord of the Rings, Games of Thrones und Marvel Universe ermöglicht das marken- und urheberrechtliche Umzäunen von kulturellen Königreichen, deren Zugang sich dann exklusiv vermarkten lässt.

Ein ähnliches Szenario ist auch für das KI-Feld absehbar: Zunehmende Exklusivdeals mit datenreichen Unternehmen garantieren einerseits eine gewisse Datenqualität aber ermöglichen auch die Ausdifferenzierung eines vermarktbaren „Flavor“ des jeweiligen KI-Outputs. Adobes Firefly brüstet sich bereits mit seinen weitestgehend legalen Trainingsdatensets, Musks xAI positioniert sich (noch erfolglos) als an X-Posts gehärtete un-woke KI, und Deals wie der von Reddit mit Google weisen ebenfalls in diese Richtung.

Völlig unabhängig davon, was bei diesen Urheberrechtsstreits herauskommt: eine Einigung ist nur eine Frage des Geldes und am Ende wird es die Vormachtstellung der KI-Unternehmen konsolidieren. Das ist einfach das, was das Urheberrecht tut: mit genügend Kapital lassen sich alle nötigen Verwertungsrechte zusammenkaufen, um damit neue, legale Königreiche zu errichten, die dann dann unangreifbare Renten abwerfen. Das alte Regime will nur noch schnell einen guten Preis rausholen. Und wer davon mal wieder gar nichts sehen wird: die Urheber.

In meinem KI-Paper für die Böckler Stiftung hatte ich letztes Jahr noch eine grundsätzliche Überlegung hinsichtlich der politischen Ökonomie der Anwendung von KI gemacht:

Bedenkt man, dass laut experimentellen Studien ein Teil der Produktivitätsgewinne der LLMs bei der Text-Produktion durch zusätzliche Korrekturarbeit wieder aufgefressen wird (Noy/Zhang 2023), ergibt sich daraus ein struktureller, ökonomischer Vorteil für Produzent*innen aller Arten von Spam und Desinformation. Akteure, die es in Kauf nehmen oder gar darauf abgesehen haben, möglichst viel Schaden anzurichten, sind schlicht viel weniger darauf angewiesen, fehlerfreie Texte zu verwenden.

Da KIs notorisch unzuverlässig sind, werden sie vor allem dort genutzt, wo es auf Verlässlichkeit nicht ankommt. Und genau das sehen wir jetzt. Die Googlesuche ist bereits immer weniger zu gebrauchen (obwohl Google jetzt Gegenmaßnahmen angekündigt hat), weil das Web im Rekordtempo mit Unsinn vollgepumpt wird. Ausgerechnet die bekannte KI-Kritikerin Emily Bender hatte dazu ein interessantes Erlebnis, nämlich dass eine Spam-News-Seite ihr KI-generierte Zitate unterjubelte – nicht als Angriff gegen sie, sondern … why not? Oder die per KI wiederbelebten Zombie-Newsseiten, wie etwa der Washington Independent, dessen ehemaliger Autor Sam Thielman darüber berichtet, wie seine alten Texte mit neuer By-Line wiederveröffentlicht wurden. Dieser Content wird nicht für Menschen veröffentlicht, sondern dient nur dazu, andere KIs (etwa den Googleaglo) zu verwirren.

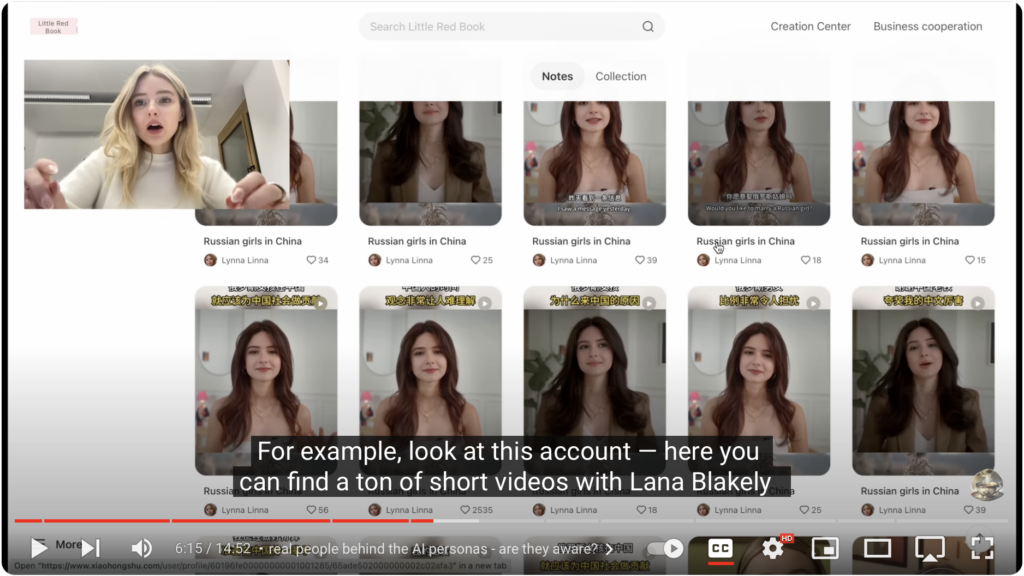

Das ist aber nichts gegen das, was im chinesischen und russischen Internet geschieht. Dort werden jetzt Gesichter und Stimmen von bekannten Influencer*innen gestohlen, die dann unter tausenden Fakeidentitäten KI-generierte Propaganda ins Netz pumpen. Dazu empfehle ich dieses wirklich gut recherchierte und durcherklärte Video von Olga Loiek, die als ukraischstämmige Influencerin mit ansehen muss, wie ihre optische Identität für russische Propagandazwecke instrumentalisiert wird.

All das passt wahnsinnig gut zu der steilen These, die ich bei Eryk Salvaggio gelesen habe: KI beendet die Ära des Informationszeitalters und entfaltet das Zeitalter des Rauschens. Rauschen, also „Noise“ bezeichnet aber nicht nur undifferenzierte Audiobelästigung, sondern ist auch ein Begriff in der mathematischen Kommunikationstheorie. Erfolgreiche Kommunikation erfordert nämlich immer die Unterscheidung von Signal und Rauschen, wobei das Rauschen gleichzeitig die Abwesenheit und überbordende Anwesenheit von Information anzeigt, etwa wie weißes Licht die gleichzeitige Abwesenheit und Überanwesenheit von Farbe bedeutet. Die Tatsache, dass Bildgenerierungs-KIs als Diffusionmodelle eben genau über die Zugabe und das Herausrechnen von Noise funktionieren, gibt Salvaggio die perfekte Metapher für seine These.

„These images are diffused, dissolved into static and the machine learns how that static moves as the image is degraded. It can walk that diffusion backward to the source image — and this is how it learns to abstract features from text into generated images. Our training data constrains what is possible to the central tendencies in that training set, the constellations of pixels most likely to match the text in the description.

In other words, it navigates averages, trading meaning for the mean. But the original context is irretrievable.“

„Trading meaning for the mean“ bringt die Funktionsweise von generativer KI perfekt auf den Punkt. Schritt für Schritt verdaut sie den gesamten Kanon der menschlichen Kultur zu einem Brei von immer kleineren, immer ähnlicheren Brocken und dieses kulturelle Exkrement blubbert nun unsere gesamte Infosphäre zu.

Im Kern besteht die politische Ökonomie der generativen KI also aus der Geiselnahme unseres kulturellen Graphen durch die Infrastukturlayer-Unternehmen. Eine Geiselnahme, die sie nun durch Urheberrechtsdeals versuchen zu legalisieren und damit zu konsolidieren. Der Plan ist, uns ein verschwommenes JPEG des Internets in Form von komprimierten Promtantworten zurück zu verkaufen, denn Lösegelder sind schließlich auch prima Renten. Wie es der Zufall so will, produzieren dieselben KIs in der Zwischenzeit so viel Unsinn, Zombiewebsites und KI-Propaganda, dass die Brücken zurück zu dem alten soziotechnischen Archiv von einem Tsunami aus Scheiße weggerissen werden und wir gar keine andere Wahl haben, als zusammen mit den Techbros auf die Erlösung durch AGI zu hoffen. Willkommen im Zeitalter des Rauschens.

@mspro @phneutral Puh, ich merke ich bin ein Fan von Zeichenlimits für Posts…

@phneutral @mspro Anreißer fände ich gut! 🙌

@mspro Super Artikel, vielen Dank!

Beeindruckend auf den Punkt gebracht. Danke

Oje.

Vielen Dank für diese Perspektive.

Pingback: Gegeneffekte in der Tech-Ökonomie - Logbuch der Kritischen Masse

Die Forderungen nach Anreißer., also Kürzung, in manchen Post hier, bestätigt nur die vorgestellte These 😀

Pingback: Krasse Links No 7. | H I E R