Willkommen bei Krasse Links No 25. Sorry, war letzte Woche krank, aber jetzt migriert Eure Publikumsjoker aus Happyland, heute vereinfachen wir die Zusammenhänge bis zur Kenntlichkeit.

Im letzten Newsletter hatte ich darauf hingewiesen, dass man etwas gegen die Macht der Milliardäre machen sollte, bevor es zu spät ist und das einfachste, was man sofort jetzt machen kann (ja, noch vor dem weiterlesen), ist diese Petition zu unterschreiben.

Einführung einer Vermögenssteuer zur Finanzierung des ökologischen und sozialen Wandels

Btw, ein wirklich toller Name für die Tech-Milliardäre ist Broligarchs. Den Begriff benutzt Brooke Harrington in ihrem tollen Stück über die durchgeknallte Silicon Valley Elite im Atlantic.

This mindset comes through in a 1997 book that Thiel has listed among his favorites of all time: The Sovereign Individual, by James Dale Davidson and William Rees-Mogg. The text unironically likens the ultrarich to “the gods in Greek myth,” and assures readers that they deserve no less than world domination: “Commanding vastly greater resources and beyond the reach of many forms of compulsion, the Sovereign Individual will redesign governments and reconfigure economies.” In describing why he included the book, Thiel said that it offered a “prophecy” of “a future that doesn’t include the powerful states that rule over us today.” Thiel has famously argued that freedom and democracy are incompatible.

Harrington führt dieses Mindset auf das Selbstverständnis der „Unverwundbarkeit“ zurück, das Menschen mit derart großem Ressourcenzugriff zwangsläufig ereilt. Sie können ihre rechtslibertären Politexperimente an der Gesellschaft nur deshalb durchführen, weil sie sich auf deren Funktionieren nicht mehr angewiesen fühlen.

And if the nation becomes a crumbling ruin, with cratering health and education levels, or roads and bridges falling to pieces, then what of it? In the short term, broligarchs can adapt to local anarchy as the ultrarich of Brazil and Mexico have done, using helicopters to commute a few blocks to work or to ferry their children to school, high above the crime-ridden streets where their fellow citizens must struggle to survive as best they can. In the long term, when their adaptations cease to protect them, they can retreat to luxury underground bunkers—complete with bowling alleys!—or even to outer space.

Eventuell sollte man „Reichtum“ endlich als psychisches Krankheitsbild anerkennen und allein zum Schutz der Betroffnen Maßnahmen zur Heilung veranlassen?

Ganz ehrlich? Ich weiß nicht mehr, was ich zu X und zu Musk noch sagen soll?

Mein Plattformbuch beginnt mit der Feststellung, dass die Tatsache, dass Plattformen viel Macht haben, ein absoluter Gemeinplatz geworden ist. Damit meinte ich nicht nur die Forschung. Jedes Provinz-Feuilleton und der Tagesschau ihre Mutter nervte jahrelang mit großen Aufmachern vor den Gefahren, die von der Macht der Plattformgiganten ausgingen.

Und irgendwie bin ich deswegen davon ausgegangen, dass, wenn so eine Plattform in die Hände von … sagen wir, einem durchgeknallten Rechtsradikalen … fällt, alle – wirklich alle – die Gefahr der Situation erkennen und gesellschaftsweit dazu mobilisieren, die Plattform in Scharen zu verlassen?

Das hat sich … nur zum Teil bestätigt, einem nach wie vor viel, viel zu geringen Teil. Und ich weiß ehrlich gesagt nicht, auf welches Ereignis die verbleibenden User noch warten? Ist der im Ansatz bereits gelungene Versuch einen Rassenkrieg in Europa anzufachen noch nicht genug?

Wer sich immer noch einredet, dass er/sie durch seine Präsenz auf X irgendwas zum Positiven bewegen kann, betreibt olympische Verdrängungsleistung. Jeder, der dort schreibt und liest, macht sich zum Teil des Problems. X mag als soziales Netzwerk an Bedeutung verlieren, aber es ist nachwievor die größte und mächtigste Nazipropagandawaffe, die es je gab. Unsere einzige Chance ist, sie irrelevant zu machen.

Wer elaboriertere Argumente braucht, darf sich gerne durch diese Links klicken.

Ich bin fertig mit dem Thema.

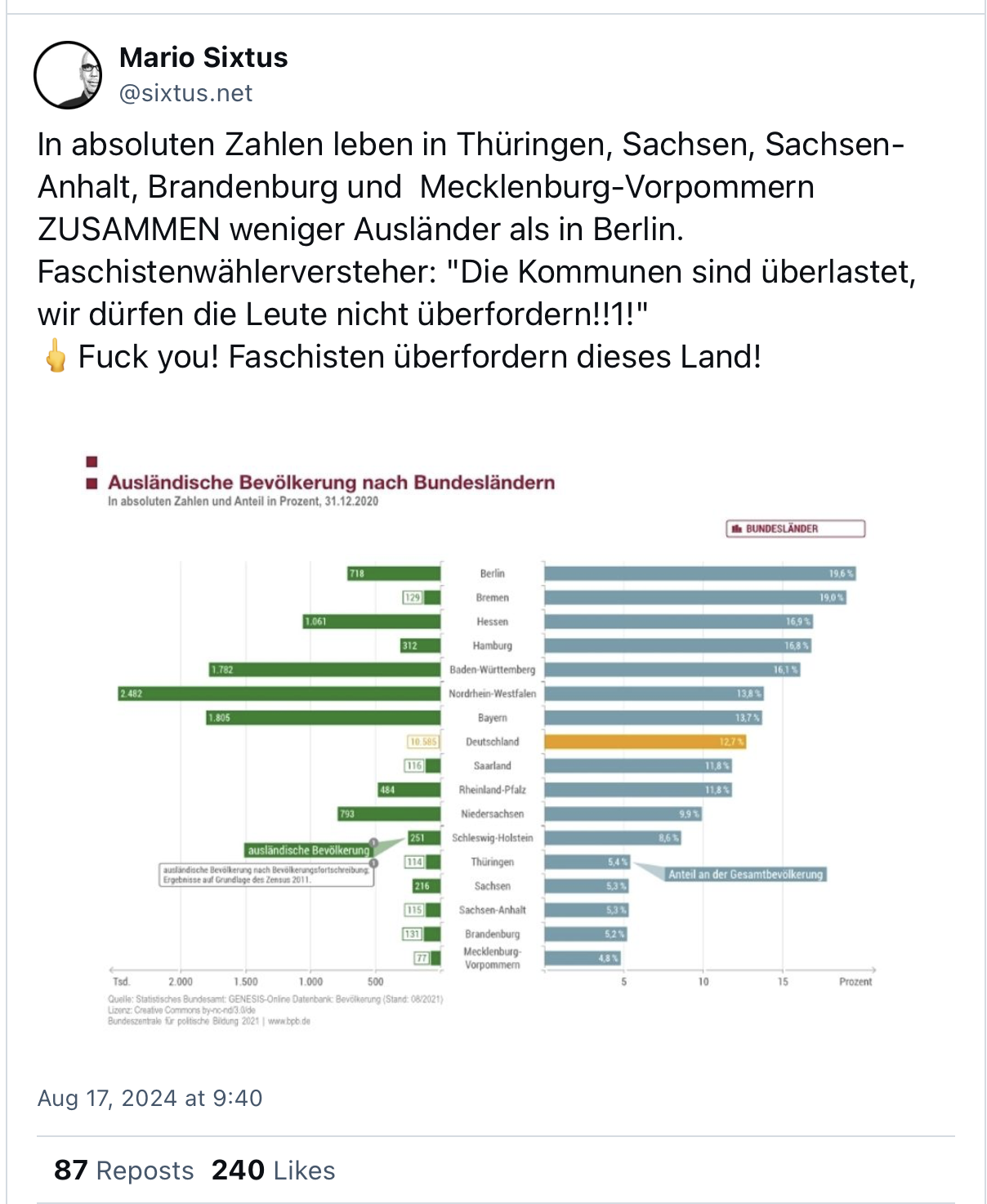

Es gibt etliche Regalmeter, die versuchen den überall aufpoppenden Rechtsradikalismus zu erklären und an den elaborierten Theorien wird hier und da etwas dran sein, aber manchmal beschleicht mich das Gefühl, dass wir die Sache komplizierter machen als sie ist?

Jedenfalls schafft es James Risen im Intercept praktisch die gesamte Politik des MAGA/Trump-Movements auf schlichten Rassismus zurückzuführen. Konkreter meint er die Angst der weißen amerikanischen Mehrheitsgesellschaft vor der sich abzeichnenden demographischen Verschiebung.

Dominated by Trump, the Republican Party adheres to policies designed both to maintain white political power and increase the white percentage of the nation’s population.

Once you understand that it is all about white power — especially white male power — the Trump-Republican agenda begins to make sense.

In der Tat:

- Pro-Natalism (mehr weiße Babys)

- Anti-Immigration, pro Deportation (gegen braune Babys)

- Abtreibungsverbot (für mehr weiße Babys)

- Anti-LGBTQ (mehr LGBTQ = weniger weiße Babys)

- Pro Putin (Verteidiger des weißen Christentums)

- Pro Israel (Vorposten gegen die Islamische Welt)

Und irgendwas sagt mir, dass das in Deutschland auch nicht so viel anders ist?

Wenn es Euch so geht wie mir, fragt ihr Euch nachwievor täglich, warum Kamala Harris‘ „weird“ so viel besser funktioniert als Joe Bidens „Democracy is on the ballot“. Ist letzteres nicht die viel größere Bedrohung?

Es gibt viele kluge Explainer, warum „weird“ funktioniert (zum Beispiel den von Jonas Schaible, dessen Newsletter sowieso in jede Inbox gehört), aber mir scheint, dass die oben gestellte Frage bereits eine Antworten enthält: „Gefahr für die Demokratie“ ist einfach eine Hausnummer zu groß?

Tupoka Ogette hatte vor einigen Jahren den Begriff „Happyland“ im Bezug auf Rassismus geprägt (Danke Susann für die Inspiration).

Fragt man die Bewohner*innen Happylands, wie es denn so um Rassismus steht in dieser Welt, wird er*sie mit an Sicherheit grenzender Wahrscheinlichkeit sagen, dass das kein großes Thema mehr ist. Mehr noch, Happyländer*innen sind überzeugte Nicht-Rassisten. Nichts läge ihnen ferner, als jemanden bewusst auszugrenzen. Jedenfalls ist das nicht Teil ihres Selbstverständnisses. Sie halten sich für offen und tolerant. Das liegt daran, dass nicht nur das Wort, sondern auch die Gedanken daran aus Happyland verbannt wurden.

Die gute Nachricht ist, dass wir gar nicht in Deutschland, Frankreich oder den USA leben, sondern alle gemeinsam in Happyland, wo alles schön und fluffig ist. Und Happyland kann gar nicht durch Rassismus bedroht sein, denn den gibt es in Happyland ja nicht. Entsprechend entlädt sich die Wut der Happylandbewohner*innen nur selten gegen Rassist*innen, sondern meist gegen Menschen, die ihre Rassismuserfahrungen öffentlich machen, diese Miesepeter!

Etwas ganz ähnliches sieht man in der Kriminalisierung des Klimaaktivismus, denn es ist ja längst wissenschaftlich erwiesen, dass Happyland weder vom Klimawandel betroffen ist noch dazu beiträgt.

Meine These wäre also: „Democracy is on the ballot“ passt genauso wenig in den Happyland-Briefkasten, wie Rassismuserfahrungen oder Klimaklebstoff. Waaas? UNSERE superduper Demokratie bedroht? Ihr spinnt doch!

Aber „weirde“ Leute passen da eben auch nicht hin? Mit denen wollen wir jedenfalls nichts zu tun haben!

Google wurde erstmals von einem Gericht als Monopol verurteilt und das wird Silicon Valley im Mark erschüttern. Es gibt dazu viel zu sagen (vielleicht ein andermal mehr), aber ich finde hier vor allem die Preissetzungsmechanismen spannend.

Googles Preisschraube setzt bei den Werbekund*innen an, die ihre Anzeigen über einen intransparentes, automatisiertes Versteigerungsverfahren buchen. Aus dem Urteil:

Google can affect the final price paid for an ad through so-called “pricing knobs” or “pricing mechanisms.” Id. at 779, 783. Google has used three primary pricing knobs to influence prices: (1) squashing, (2) format pricing, and (3) randomized generalized second-price auction.

Die „Knöpfe“ sind nicht direkt Preissetzend, aber erhöhen künstlich den Wettbewerbsdruck um die gebuchten Keywords, was dann wiederum den Endpreis erhöht. Aus Sicht der Werbekund*innen ist das natürlich null nachvollziehbar.

Alistair Barr rantet im Wallstreet Journal lesenswert über die Legacy von Silivon Valley:

Streaming is now just as expensive and confusing as cable. Ubers cost as much as taxis. And the cloud is no longer cheap.

Ich seh das so: Ab etwa 2010 fing das Silicon Valley an, das Plattformgeschäftsmodell wirklich zu verstehen. Welche Dynamiken Netzwerkeffekte entfalten, wie Graphnahmen funktionieren, welche strategische Rolle Skalierung spielt, und wie und welche Leute man zum Bezahlen bekommt und wie man dann langsam per Enshittyfication an den „Pricing Nobs“ dreht, um den Druck auf der Cashflow-Pipline beliebig zu erhöhen.

Am Ende war es ein gesellschaftsweiter Enkeltrick: „Cut out the Middlemen“, hieß es, also ersetze etablierte Infrastrukturen durch diese „shiny new“ Infrastrukturen, die viel, viel zentralisierter sind und uns durch ihren ungleich stärken LockIn immer abhängiger gemacht haben, während wir die Alternativen haben verrotten lassen. Und jetzt werden wir halt ausgequetscht.

Large Language Models sind scheißekomplexe Systeme und es hat mich sehr viel Zeit und Anstrengung gekostet auch nur eine grobe Vorstellung davon zu bekommen, wie sie funktionieren. Auf der anderen Seite gibt es immer wieder super praktische Explainer und dieser hier ist deswegen bemerkenswert, weil man da einfach direkt mit rumspielen kann.

Ein in der KI-Diskussion immer wieder auftauchender Begriff ist der der „Emergent Abilities“ und jetzt hat ein Paper wahrscheinlich die Nuss geknackt, was dahintersteckt.

Kurz zusammengefasst beziehen sich Emergent Abilities auf die Beobachtung, dass LLMs ab einer bestimmten Skalierung neue, vorher nicht gekannte Fähigkeiten zeigen, etwa „In Context Learning“, „Step-by-step reasoning“ und die Fähigkeit, bestimmte Benchmarks zu erreichen. Der Begriff stammt aus einem Google-Paper, wurde aber kurz danach von anderen Forscher*innen als Mirage bezeichnet und seitdem geht die Diskussion.

Zusammen mit den „Scaling Laws“ stehen die „ermergent Abilities“ im Zentrum der Debatte, in wie weit LLMs fähig sind zu „denken“, oder ob sie eben doch nur stochsatische Papageien sind. Ich positionierte mich neulich ja (endlich) auf der Papageien-Seite und fand die Beschreibung der „Reasoningfähigkeiten“ als semantische „Programme“ plausibel, die Francois Chollet aufgebracht hat. Aber wie genau funktioniert das?

Dieses Paper kommt der Auflösung des Rätsels m.E. ein ganzes Stück weit näher (danke Julian). Um ihren Ansatz zu verstehen muss man wissen, dass es neben dem Basistraining der LLMs, bei dem ihnen die riesigen Textkorpora eingeprügelt werden, noch weitere Schritte des Trainings gibt, die man „Fine-Tuning“ nennt. Grob gesprochen erhalten die Modelle im Basistraining ihr Wissen und ihre Sprachfähigkeiten und im Fine-Tuning bekommen sie beigebracht, sich auf eine bestimmte Art zu verhalten, z.B. ein hilfreicher Chatbot zu sein.

Ein wichtiger Teil des Fine-Tuning ist wiederum das Instruction-Tuning, das ist, wo die Modelle beigebracht bekommen, wie man gut auf Prompts reagiert und entsprechend bestehen die Trainingsdaten aus etlichen Prompt-Antwort-Beispielen.

Die (experimentell unterfütterte) These der Forscher*innen ist nun, dass es diese Instruction-Tuning-Beispiele sind, auf die die LLMs als „semantische Programme“ zurückfallen, wenn sie „In Context Learning“ (ICL) praktizieren.

We propose that instruction-tuning enables models to map instructions to the form required for ICL, thus allowing instruction-tuned models to solve tasks using some implicit form of ICL. Importantly, during this process, models could be directly making use of the same underlying mechanism that makes ICL possible, just in a different way than when the model explicitly makes use of ICL from examples provided in the prompt. We call this use of ICL ‘implicit’ in-context learning. Performing such a mapping would be relatively straightforward for a very large model, especially given that this task format aligns closely with the training process carried out during instruction-tuning.

Ich weiß, das ist alles furchtbar kompliziert und verwirrend und der „stochastische Papagei“ erklärt dabei herzlich wenig, deswegen hier die kürzeste LLM-Erklärung, die mir bisher eingefallen ist:

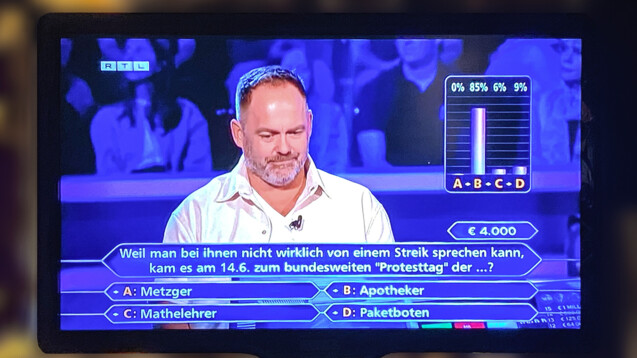

LLMs funktionieren wie der Publikumsjoker bei Wer wird Millionär: Es gibt immer einen Satz, der vervollständigt werden muss, und die Mehrheitsentscheidung des Publikums bestimmt wie.

Und der Grund, warum LLMs funktionieren, ist derselbe, warum der Zuschauerjoker überraschend oft funktioniert. Das Publikum teilt eine gemeinsame Landkarte des Wissens, aber jede einzelne Person hat einen leicht anderen Ausschnitt. Die meisten Teile überschneiden sich, doch der eine kennt sich eher im Gartenbau aus, die andere in der Philosophie, der nächste in Technik und wieder eine andere ist viel gereist. Einzeln haben sie große Wissenslücken, aber gemeinsam decken sie ziemlich viel Territorium ab und wo sich ihr Wissen überschneidet, akkumuliert sich eine hohe Treffsicherheit.

Bei LLMs besteht das Publikum aus den Millionen Trainings-Texten und die Mehrheitsentscheidung passiert als Wahrscheinlichkeitsrechnung, aber das grobe Prinzip ist tatsächlich dasselbe.

Nun kann man das Ergebnis des Publikumsjokers erheblich verbessern, indem man das Publikum von 10 auf 100 vergrößert, wahrscheinlich auch noch, wenn man weiter auf 1000 skaliert, aber ein Publikum von einer Millionen wird nur homöopathisch besser sein als die Tausend. Kurz: Wir stoßen – wie bei den LLMs – auf „deminishing Returns“ und die Idee, dass ein Milliardenpublikumsjoker eine Superintelligenz triggert, wirkt ziemlich abwegig?

Die Leute bei OpenAI haben eine Methode gefunden, wie man Watermarks in LLM-generierte Texte integrieren kann, also die Texte so produzieren kann, dass man sie als LLM-Output automatisiert erkennen kann.

ChatGPT is powered by an AI system that predicts what word or word fragment, known as a token, should come next in a sentence. The anticheating tool under discussion at OpenAI would slightly change how the tokens are selected. Those changes would leave a pattern called a watermark.

The watermarks would be unnoticeable to the human eye but could be found with OpenAI’s detection technology. The detector provides a score of how likely the entire document or a portion of it was written by ChatGPT.

The watermarks are 99.9% effective when enough new text is created by ChatGPT, according to the internal documents.

Natürlich weigert sich OpenAI die Methode auszurollen. Den Grund dafür brachte Ethan Mollick schon vor einem Jahr auf den Punkt:

„Much of the value of AI use comes from people not knowing you are using it.“

Hey EU, ich hätte da eine Idee für eine Regulierung?

Die KI-Blase ist immer noch nicht geplatzt, obwohl praktisch alle nicht gehirngewaschenen Menschen „Bullshit“ gecalled haben und es macht Sinn sich zu fragen, wieso?

Ein offensichtlicher Grund scheint zu sein, dass Silicon Valley einfach die Alternativen fehlen. Das Plattformgeschäftsmodell hat grob von 2008 bis 2018 immer neue lukrative StartUps produziert, ist aber spätestens mit der fraglichen Wirtschaftlichkeit von WeWork, Uber und AirBnB outgefizzelt. Und seitdem rudern sie: Crypto, Metaverse und nun eben generative KI. Platzt KI, steht Silicon Valley ziemlich nackt da. Brian Merchant:

That’s what makes this such a wild moment. Because *despite all that* big tech has absolutely convinced itself that generative AI is the future, and thus far they’re apparently unwilling to listen to anyone else—even, so far, the money!—who pretty clearly thinks otherwise. Maybe they just don’t have any other viable ideas as to what to hype next if generative AI doesn’t pan out. Maybe they consider the sunk costs too high to jump ship. Maybe they’re genuinely worried that if they don’t crack the code and make an AI that can reliably do all the stuff they’ve promised AI can do someday, a competitor will. Maybe they’re seeing something most of us aren’t seeing. Who knows.

Nun ist das Plattformgeschäftsmodell für die Techfirmen nach wie vor unfassbar lukrativ und füllt zuverlässig ihre Geldspeicher.

The largest tech companies in the world are also the richest. Apple increase; Amazon, Microsoft and the parent companies of Google and Facebook now collectively sit on a little more than $570 billion in cash, short-term and long-term investments. That is more than double the collective pile of the next five richest nonfinancial companies on the S&P 500 index, according to data from S&P Global Market Intelligence.

Was sollen sie sonst mit dem Cash tun? Sinnvolle Produkte bauen? In ETFs anlegen? Den Welthunger besiegen?

Dazu kommt noch das viele Geld von Saudi Arabien und den Vereinigten Arabischen Emiraten. Die Washington Post hat einen sehr lesenswerten Artikel dazu:

Microsoft last month announced a $1.5 billion investment in G42, the United Arab Emirates’ flagship tech firm, which also has an agreement to use AI language models from Sam Altman’s OpenAI. Prominent venture capital firm Andreessen Horowitz is in talks to raise $40 billion from Saudi Arabia for a dedicated AI fund.

Mit ihren fast 2 Billionen („Trillions“ im Englischen) verfügbaren Reserven haben sich die beiden Öl-Dikaturen zu den größten nicht-US-basierten Finanziers Silicon Valleys im Allgemeinen und generativer KI im besonderen gemausert und es wird immer schwieriger, sich daran zu erinnern, dass Menschenrechte – zumindest in der Öffentlichkeitsarbeit der Tech-Konzerne – einmal eine Rolle spielten.

Some tech entrepreneurs and venture firms once shunned Middle Eastern funding, driven by concern for human rights abuses, the region’s ties to China and industry disdain for what were once considered lucrative, but unsophisticated, investments, deemed “dumb money,” from oil states. The 2018 killing of Saudi journalist and Washington Post contributor Jamal Khashoggi caused some firms to explicitly step away from the country’s cash.

But Middle Eastern money has become the most powerful geopolitical force in the tech industry virtually overnight. “The Khashoggi era is over,” said a prominent venture capitalist.

Der eigentliche Twist der Story besteht aber darin, dass auch Washington seine Finger im Spiel hat. Generative KI ist derzeit das Hauptargument, mit dem die USA China aus dem neuen Technologie-Mekkah „outcrowden“ will:

Given the state of technology competition with China, “it’s going to be hard to coexist in both systems,” officials told their UAE counterparts, according to a senior administration official. ‘Look, you’re going to have to choose if you want to access that technology.‘

Before Microsoft invested in G42, the Biden administration won assurances the UAE company would divest from Chinese firms, remove Chinese technology from its data centers and would work to prevent advanced capabilities from leaking to China.

Nicht nur Silicon Valley ist davon abhängig, den KI-Hype aufrecht zu halten, sondern auch die Biden-Administration. Künstliche Intelligenz ist derzeit der wichtigste Motor westlich-geopolitischer Korruption.

John Oliver hat einen Beitrag über die Zustände im Westjordanland gemacht und international anerkannte Mainstream-Commedians und ihre gut recherchierten Beiträge sind meine letzte Hoffnung gegen die deutsche Staatsraison.

Das Israelische Magazin +972Mag, das bereits einige der KI-Programme, mit denen der Massenmord in Gaza durchgeführt wird, enttarnt hat, berichtet über die Nutzung kommerzieller Cloud-Infrastrukturen durch das israelische Militär.

But the “most important” advantage that the cloud companies provided, Dembinsky said, was their advanced capabilities in artificial intelligence. “The crazy wealth of services, big data and AI — we’ve already reached a point where our systems really need it,” she said with a smile. Working with these companies, she added, has granted the military “very significant operational effectiveness” in the Gaza Strip.

Gaza wird mit einer Intensität und Lückenlosigkeit überwacht, die wahrscheinlich einzigartig ist auf der Welt und das braucht einfach ne Menge Computerpower?

Military sources emphasized to +972 and Local Call that the scope of intelligence collected from the surveillance of all Palestinian residents of Gaza is so large that it cannot be stored on military servers alone. In particular, according to intelligence sources, much more extensive storage capabilities and processing power were needed to keep billions of audio files (as opposed to just textual information or metadata), which compelled the army to turn to the cloud services offered by tech companies.

Und alle sind mit dabei: Google, Amazon, Microsoft. Die Cloud ist jetzt eine Kriegswaffe und eventuell liegt dein Facebook-Profilbild auf demselben Server wie die Zielkoordinaten eines palästinensischen Krankenhauses.

Das betrifft auch Social Media. Der EFF veröffentlichte einen Appell an die Tech-Unternehmen, Israels staatlicher „Cyber Unit“ keinen präferierten Zugang mehr für Moderationsanfragen mehr zur Verfügung zu stellen, mit dem sie sehr erfolgreich Jagd auf Pro-Palästinensische Meinungsäußerungen macht.

This is not new. The Cyber Unit has long boasted that its takedown requests result in high compliance rates of up to 90 percent across all social media platforms. They have unfairly targeted Palestinian rights activists, news organizations, and civil society; one such incident prompted Meta’s Oversight Board to recommend that the company “Formalize a transparent process on how it receives and responds to all government requests for content removal, and ensure that they are included in transparency reporting.”

Nirgends sieht man die Verschmelzung von Silicon Valley mit dem Industriell-Militärischen Komplex schneller voranschreiten, als im Gravitationsfeld von Palantir.

Palantir Technologies Inc. (NYSE: PLTR) and Microsoft Corporation (NASDAQ: MSFT) announce today a significant advancement in their partnership to bring some of the most sophisticated and secure cloud, AI and analytics capabilities to the U.S. Defense and Intelligence Community. This is a first-of-its-kind, integrated suite of technology that will allow critical national security missions to operationalize Microsoft’s best-in-class large language models (LLMs) via Azure OpenAI Service within Palantir’s AI Platforms (AIP) in Microsoft’s government and classified cloud environments.

I keep telling you: Gaza ist nur der Testfall.